Doris在大数据视频分析中的应用创新

Doris在大数据视频分析中的应用创新

关键词:Doris数据库、大数据视频分析、实时OLAP、多维聚合、高并发查询

摘要:随着短视频、直播等视频业务的爆发式增长,视频平台面临着海量数据实时分析的挑战——既要处理每秒百万级的播放日志,又要支持“某地区过去10分钟不同设备的播放完成率”这类复杂多维查询。传统数据库要么延迟高(如Hive离线处理),要么无法支持复杂聚合(如Redis缓存)。本文将以“Doris如何破解视频分析难题”为主线,结合生活案例、技术原理和真实实战,揭秘Doris在大数据视频分析中的四大创新应用,帮助读者理解这个“实时分析神器”的核心价值。

背景介绍

目的和范围

本文聚焦“Doris在大数据视频分析中的创新应用”,覆盖从技术原理到实战落地的全链路。既适合视频平台的开发/数据工程师学习如何用Doris优化分析系统,也适合对大数据技术感兴趣的读者理解OLAP数据库的实际价值。

预期读者

- 视频平台数据分析师(想了解如何快速获取精准分析结果)

- 大数据开发工程师(想优化现有视频分析架构)

- 技术管理者(想评估Doris是否适合团队业务)

- 技术爱好者(对“如何处理每天10亿条视频日志”好奇的朋友)

文档结构概述

本文将按“问题引入→核心概念→创新应用→实战案例→未来趋势”的逻辑展开。先通过“短视频平台的凌晨告警”故事引出视频分析的痛点,再用“超市货架”“预制菜”等生活比喻解释Doris的核心特性,接着重点讲解Doris在视频分析中的四大创新场景,最后用某头部平台的真实案例验证效果。

术语表

核心术语定义

- OLAP(在线分析处理):像“数据侦探”,专门处理复杂的统计查询(如“各省份过去1小时播放量TOP10的视频”)。

- MPP(大规模并行处理):一群“分工明确的快递员”,把大任务拆成小任务并行处理,比如同时统计华北、华东、华南的播放量。

- 列式存储:数据按列存储(如所有用户ID存一起,所有播放时长存一起),像超市把饮料、零食、日用品分货架摆放,方便快速“拿一类商品统计”。

- 预聚合:提前把常用的统计结果算好(如“每小时各地区播放量”),查询时直接取结果,像“预制菜”提前切好食材,炒菜更快。

缩略词列表

- Doris:原百度 Palo 项目,现开源的高性能分析型数据库。

- MPP:Massively Parallel Processing(大规模并行处理)。

- OLAP:Online Analytical Processing(在线分析处理)。

核心概念与联系

故事引入:短视频平台的凌晨告警

凌晨3点,某短视频平台的技术主管被手机闹钟惊醒——监控大屏显示“最近10分钟播放量统计延迟2小时”,运营同事正急着要数据调整推荐策略。原来,平台用Hive离线处理日志,每天凌晨跑批,但最近用户量暴增,Hive处理时间从2小时延长到4小时;而尝试用Redis缓存实时数据,却查不了“按地区+设备+时间段”的多维聚合,只能得到“总播放量”。这时候,Doris像“急救医生”一样被引入,3天后问题解决:播放量统计从4小时→10秒,复杂查询从“无法支持”→“秒级响应”。

核心概念解释(像给小学生讲故事)

核心概念一:Doris——实时分析的“超级计算器”

Doris是一个专门处理“海量数据快速统计”的数据库。想象你有一个“智能记账本”,不仅能实时记录每一笔“视频播放”流水(比如用户A在10:00:01看了视频X),还能立刻回答你:“今天上午广东地区用iPhone的用户,看了超过30秒的视频有多少?”传统数据库要么只能事后慢慢算(离线数据库),要么只能记流水账(缓存数据库),而Doris能同时做到“实时记”和“快速算”。

核心概念二:大数据视频分析的三大痛点

视频分析的数据像“潮水”:

- 量大:一个千万DAU的平台,每天产生10亿+播放日志(每条日志包含用户ID、视频ID、设备、地区、播放时长等30+字段)。

- 实时:运营要“最近10分钟各城市的播放趋势”,来调整热门视频推荐。

- 复杂:不仅要“总播放量”,还要“按地区+设备+用户年龄”的交叉分析(比如“20-30岁用户,在华为手机上,晚上8点后观看超过1分钟的视频占比”)。

核心概念三:Doris的四大“超能力”

Doris能解决视频分析痛点,靠的是四个“超能力”:

- 实时写入:像“高速收费站”,每秒能处理百万条播放日志,且写入后立刻能查(传统离线数据库要等批量导入)。

- 列式存储:数据按列存(比如所有“播放时长”存一起),查“播放时长>30秒”时,只需要扫描这一列,像超市找“可乐”只逛饮料区,不用跑遍所有货架。

- 预聚合:提前算好常用的统计结果(比如“每小时各地区播放量”),查询时直接取结果,不用每次重新计算,像“预制菜”提前切好菜,炒菜更快。

- MPP并行计算:把大查询拆成多个小任务,由多台服务器同时算(比如同时统计华北、华东、华南的数据),像“分工合作搬砖”,比一个人搬快得多。

核心概念之间的关系(用小学生能理解的比喻)

Doris的“超能力”和视频分析的需求,就像“钥匙”和“锁”的关系:

- 实时写入 ↔ 视频数据的实时性需求:就像你刚买了零食,超市收银台立刻录入系统,你转身就能查“今天卖了多少包薯片”。

- 列式存储 ↔ 复杂多维查询需求:视频分析常需要按某几个字段(如地区、设备)统计,列式存储让Doris能快速“挑出”这些字段计算,就像你要统计“红色包装的零食”,只需要看所有零食的包装颜色列,不用看价格、口味等其他列。

- 预聚合 ↔ 高频查询的效率需求:视频平台每天要查很多次“各地区播放量”,预聚合相当于提前把这些结果存好,查询时直接取,不用每次重新算,就像妈妈提前把第二天的菜切好,早上炒菜更快。

- MPP并行计算 ↔ 海量数据的处理需求:当视频日志量极大(比如10亿条),MPP让多台服务器同时处理不同的数据块,就像全班同学一起抄作业,比一个人抄快得多。

核心概念原理和架构的文本示意图

Doris的核心架构可简化为“写入→存储→查询”三阶段:

- 写入阶段:实时接收播放日志(通过Broker或Stream Load),按分区/分桶规则分散到不同节点。

- 存储阶段:数据以列式存储,同时根据表类型(如聚合表)自动预聚合(比如按“地区+小时”聚合播放量)。

- 查询阶段:SQL请求被拆分为多个子任务(MPP),各节点并行计算后汇总结果。

Mermaid 流程图

视频播放日志

实时写入Doris

列式存储+预聚合

用户查询请求

MPP并行计算

返回秒级结果

核心算法原理 & 具体操作步骤

Doris能高效处理视频分析查询,关键靠两大“幕后英雄”:列式存储优化和预聚合算法。我们以“统计某小时各地区播放量”为例,看Doris如何工作。

列式存储如何加速查询?

假设视频日志表有如下字段:user_id, video_id, region, device, play_duration, timestamp(用户ID、视频ID、地区、设备、播放时长、时间戳)。

传统行式存储(如MySQL)会把每一行数据存一起(比如一行是“用户1,视频A,广东,iPhone,60秒,10:00:00”),查“各地区播放量”时,需要扫描所有行的region和play_duration字段,效率低。

Doris的列式存储则把同一列的数据存一起(如图1):

-

region列:[广东, 北京, 广东, 上海, …] -

play_duration列:[60, 30, 90, 45, …]

查“各地区播放量”时,只需要扫描region列和play_duration列,其他列(如user_id)不用管。列式存储的优势在字段多、查询只涉及少数列时更明显(视频日志通常有30+字段)。

预聚合:提前算好结果

Doris支持“聚合表”,创建表时可以定义聚合规则(如SUM(play_duration)按region+hour(timestamp)分组)。当新数据写入时,Doris会自动按规则聚合,相当于提前生成一个“各地区每小时播放量汇总表”。

示例SQL(创建聚合表):

CREATE TABLE video_play_aggregate (

region VARCHAR(20),

hour_time DATETIME,

total_play_duration BIGINT SUM

)

DUPLICATE KEY(region, hour_time) -- 按地区和小时分组

DISTRIBUTED BY HASH(region) BUCKETS 16 -- 按地区分桶,分散到不同节点

PROPERTIES (

"replication_num" = "3", -- 3副本保证高可用

"storage_format" = "V2" -- 列式存储格式

);

当一条新日志(地区=广东,时间=10:05:00,播放时长=60秒)写入时,Doris会自动计算:hour_time=10:00:00,然后将total_play_duration在“广东+10:00:00”的分组下累加60。查询时,直接读取聚合表,无需扫描原始日志,效率提升10-100倍。

MPP并行计算:分任务一起干

假设有10亿条日志,Doris会按分桶规则(如按region哈希分16桶)把数据分到16个节点。当查询“各地区播放量”时,每个节点只需要计算自己桶内的数据,最后将结果汇总(如图2)。就像16个同学各自统计自己的作业本,最后班长把结果加起来,比一个人统计10亿条快得多。

数学模型和公式 & 详细讲解 & 举例说明

视频分析中最常见的统计是多维聚合,数学上可表示为:

R

e

s

u

l

t

=

∑

i

=

1

n

f

(

x

i

1

,

x

i

2

,

.

.

.

,

x

i

k

)

Result = \sum_{i=1}^n f(x_{i1}, x_{i2}, …, x_{ik})

Result=i=1∑nf(xi1,xi2,…,xik)

其中,

x

i

1

,

x

i

2

,

.

.

.

,

x

i

k

x_{i1}, x_{i2}, …, x_{ik}

xi1,xi2,…,xik 是维度字段(如地区、设备、时间),

f

f

f 是聚合函数(如SUM播放时长、COUNT播放次数)。

Doris通过预聚合将这个计算从“运行时”提前到“写入时”。假设我们定义维度为region和hour,聚合函数为SUM(play_duration),则预聚合后的结果表满足:

P

r

e

A

g

g

R

e

s

u

l

t

(

r

e

g

i

o

n

,

h

o

u

r

)

=

∑

t

∈

[

h

o

u

r

,

h

o

u

r

+

1

)

p

l

a

y

_

d

u

r

a

t

i

o

n

(

t

)

PreAggResult(region, hour) = \sum_{t \in [hour, hour+1)} play\_duration(t)

PreAggResult(region,hour)=t∈[hour,hour+1)∑play_duration(t)

当查询SUM(play_duration) WHERE region=广东 AND hour=10时,直接读取PreAggResult(广东, 10)即可,无需遍历原始数据。

举例:

原始日志有3条:

- (广东, 10:05:00, 60秒)

- (广东, 10:15:00, 90秒)

- (北京, 10:25:00, 45秒)

预聚合后,结果表为:

| region | hour | total_play_duration |

|---|---|---|

| 广东 | 10:00:00 | 150(60+90) |

| 北京 | 10:00:00 | 45 |

查询“广东地区10点的总播放时长”时,直接返回150秒,无需扫描原始日志。

项目实战:某视频平台的Doris落地案例

背景与痛点

某头部短视频平台日活2亿,每天产生80亿条播放日志(每条50+字段)。原有架构:

- 实时部分:Kafka接收日志→Flink清洗→Redis缓存(存总播放量),但无法支持多维查询(如“广东+iPhone+晚上8点”的播放量)。

- 离线部分:Hive每天凌晨处理日志,次日9点出前一天的统计结果,无法满足“分钟级”运营需求。

核心需求: 实现“秒级实时写入+复杂多维查询秒级响应”。

开发环境搭建

- 集群规模:10台物理机(CPU 32核,内存256G,磁盘1T SSD),部署Doris 1.2.4版本。

- 数据接入:Flink清洗后的日志通过Doris的Stream Load接口实时写入(支持HTTP/JSON格式)。

- 监控工具:Prometheus+Grafana监控Doris的QPS、延迟、节点负载。

源代码详细实现和代码解读

步骤1:设计表结构(关键!)

根据视频分析的高频查询场景(如按“时间+地区+设备”统计播放量、完播率),设计聚合表和明细层表:

-

聚合层表(video_play_aggregate):存储预聚合结果,用于高频查询。

CREATE TABLE video_play_aggregate ( event_time DATETIME, -- 时间维度(精确到小时) region VARCHAR(20), -- 地区维度 device VARCHAR(20), -- 设备维度 play_count BIGINT SUM, -- 播放次数(聚合函数) complete_count BIGINT SUM, -- 完播次数(播放时长≥视频时长) total_play_duration BIGINT SUM -- 总播放时长 ) DUPLICATE KEY(event_time, region, device) -- 按时间、地区、设备分组 DISTRIBUTED BY HASH(region) BUCKETS 16 -- 按地区分桶,分散负载 PROPERTIES ( "replication_num" = "3", "storage_format" = "V2", "dynamic_partition.enable" = "true", -- 动态分区(按天自动创建分区) "dynamic_partition.time_unit" = "DAY", "dynamic_partition.start" = "-30", -- 保留最近30天数据 "dynamic_partition.end" = "1" );设计思路:选择

event_time(时间)、region(地区)、device(设备)作为维度,因为这三个字段是运营最常查询的组合;使用SUM聚合函数,因为需要统计次数和时长。 -

明细层表(video_play_detail):存储原始日志,用于偶尔的深度分析(如排查异常数据)。

CREATE TABLE video_play_detail ( user_id BIGINT, video_id BIGINT, event_time DATETIME, region VARCHAR(20), device VARCHAR(20), play_duration INT, video_duration INT -- 视频总时长(用于判断是否完播) ) DUPLICATE KEY(event_time) -- 按时间排序,优化时间范围查询 DISTRIBUTED BY HASH(video_id) BUCKETS 32 -- 按视频ID分桶,分散相同视频的查询压力 PROPERTIES ( "replication_num" = "3", "storage_format" = "V2" );

步骤2:数据写入

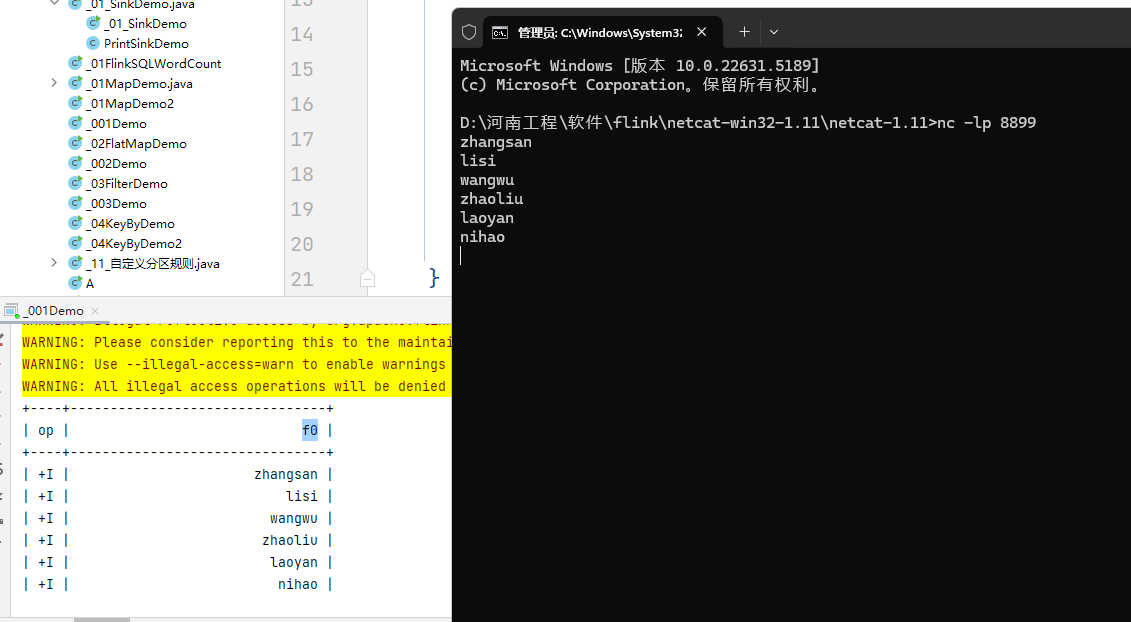

使用Doris的Stream Load接口,通过Flink实时写入清洗后的日志。Flink代码示例(Java):

// Flink将清洗后的日志转为JSON格式

DataStream<String> cleanedLog = ...;

// 使用Doris的Stream Load客户端写入

cleanedLog.addSink(new DorisSink(

"http://doris-fe:8030/api/db/video_play_aggregate/_stream_load",

"username",

"password"

));

关键参数:stream_load支持批量写入(每批10万条),写入延迟≤5秒,且写入后立即生效(可查询)。

步骤3:查询优化(关键!)

针对高频查询“最近1小时各地区+设备的播放完成率”(完成率=完播次数/播放次数),Doris自动利用聚合层表快速计算:

SELECT

region,

device,

SUM(complete_count) / SUM(play_count) AS complete_rate

FROM video_play_aggregate

WHERE event_time >= DATE_SUB(NOW(), INTERVAL 1 HOUR)

GROUP BY region, device;

执行过程:

- Doris根据

event_time过滤最近1小时的数据(动态分区自动定位到对应分区)。 - 按

region和device分组,直接读取预聚合的play_count和complete_count。 - 计算完成率并返回结果,耗时≤500ms(传统Hive需要5分钟+)。

代码解读与分析

- 表结构设计:聚合层表通过预聚合将“运行时计算”转为“写入时计算”,适合高频多维查询;明细层表保留原始数据,用于灵活的深度分析。

-

分桶策略:聚合层按

region分桶,确保相同地区的数据分布在同一节点,减少跨节点通信;明细层按video_id分桶,分散热门视频的查询压力。 - 动态分区:自动管理时间分区(保留最近30天数据),避免人工维护分区的麻烦,同时节省存储。

实际应用场景

Doris在视频分析中可覆盖从“实时监控”到“用户画像”的全场景,以下是四大典型场景:

1. 实时运营监控大屏

运营同学需要实时看到“各地区播放量TOP10视频”“不同设备的完播率趋势”等指标。Doris的秒级查询响应,让监控大屏数据每10秒刷新一次,比传统离线方案(每天更新)和缓存方案(仅支持简单统计)更强大。

2. 用户行为深度分析

分析“某类用户(如20-30岁女性)在晚上8-10点,观看超过3分钟的视频类型偏好”。Doris的列式存储支持快速过滤用户属性(年龄、性别)和行为字段(播放时长、视频类型),复杂查询从“小时级”缩短到“分钟级”。

3. 内容推荐优化

推荐算法需要实时知道“某视频在过去30分钟的播放量/点赞量/分享量”,以调整推荐策略。Doris的实时写入+低延迟查询,让推荐模型能获取“最新鲜”的数据,提升推荐准确率。

4. 广告效果评估

广告主需要“某广告在各地区、各时段的曝光量、点击量、转化率”。Doris支持多表关联(如广告曝光日志+用户点击日志),快速计算广告ROI,帮助广告主优化投放策略。

工具和资源推荐

- Doris官方文档:https://doris.apache.org/zh-CN/docs(必看!涵盖安装、配置、SQL语法)。

-

Doris生态工具:

- DBeaver:可视化连接Doris,方便写SQL查询(替代命令行)。

- Flink-Doris-Connector:Flink实时写入Doris的官方连接器(简化数据接入)。

- Prometheus+Grafana:监控Doris的QPS、延迟、节点状态(推荐配置模板:Doris监控模板)。

- 学习社区:Doris知乎专栏、GitHub Issues(遇到问题可直接向社区提问)。

未来发展趋势与挑战

趋势1:多模态数据融合分析

视频数据不再是“孤立”的,未来需要结合用户评论(文本)、视频封面(图像)、播放时的设备状态(如网络类型)进行多模态分析。Doris正在扩展对JSON、ARRAY等复杂数据类型的支持,未来可直接存储和分析多模态数据,无需额外转换。

趋势2:与AI模型深度集成

视频分析中常需要用AI模型提取特征(如视频内容标签、用户情绪识别)。Doris计划支持“UDF(用户自定义函数)集成AI模型”,例如在查询时直接调用预训练的分类模型,实时给视频打标签,再统计“搞笑类视频的播放量”。

挑战1:超大规模数据的存储优化

随着4K/8K视频普及,视频日志的字段数和数据量将进一步增长(如新增“分辨率”“码率”字段)。Doris需要优化列式存储的压缩算法(如针对浮点数的更高效压缩),降低存储成本。

挑战2:实时与离线的统一分析

部分视频分析场景需要“既查实时数据,又查历史数据”(如对比“今天10点”和“上周10点”的播放量)。Doris需要加强“实时-离线”数据的统一查询能力,避免用户维护两套系统。

总结:学到了什么?

核心概念回顾

- Doris:实时分析数据库,擅长“海量数据+复杂查询+低延迟响应”。

- 视频分析痛点:数据量大、实时性高、查询复杂。

- Doris的超能力:实时写入、列式存储、预聚合、MPP并行计算。

概念关系回顾

Doris的“超能力”精准解决视频分析的痛点:

- 实时写入→满足实时性需求;

- 列式存储+MPP→应对海量数据和复杂查询;

- 预聚合→加速高频统计。

思考题:动动小脑筋

- 如果你是某视频平台的数据工程师,需要分析“用户观看短视频时,拖动进度条的行为对完播率的影响”,你会如何设计Doris的表结构?需要哪些维度和聚合函数?

- 假设Doris集群的查询延迟突然升高,可能的原因有哪些?如何通过监控工具定位问题?(提示:可从分桶策略、数据倾斜、查询复杂度等角度思考)

附录:常见问题与解答

Q1:Doris和ClickHouse有什么区别?

A:两者都是OLAP数据库,但Doris更侧重“实时写入+复杂查询的平衡”,支持动态分区、多租户资源隔离,适合企业级场景;ClickHouse在单表查询性能上更强,但实时写入和运维复杂度较高。

Q2:视频元数据(如视频时长、分类)和播放日志如何关联?

A:可通过Doris的JOIN操作关联两张表(如video_info表存储视频元数据,video_play_log表存储播放日志)。建议将video_info表设为“维度表”(小表),通过广播JOIN优化性能。

Q3:数据倾斜如何处理?

A:数据倾斜指某一分桶的数据量远大于其他分桶(如某地区的播放日志特别多)。可通过调整分桶键(如将region+device组合作为分桶键)分散数据,或使用Doris的“倾斜优化”功能(自动将大分桶拆分为多个子分桶)。

扩展阅读 & 参考资料

- 《Doris官方文档:核心概念》https://doris.apache.org/zh-CN/docs/dev/concepts/

- 《大数据视频分析技术白皮书》阿里云技术博客

- 《OLAP数据库对比:Doris vs ClickHouse》InfoQ