浅谈大数据领域 HDFS 的数据冗余策略

浅谈大数据领域 HDFS 的数据冗余策略

关键词:HDFS、数据冗余、副本策略、容错机制、分布式存储、数据可靠性、大数据存储

摘要:本文深入探讨了Hadoop分布式文件系统(HDFS)中的数据冗余策略。作为大数据生态系统的核心存储组件,HDFS通过精心设计的数据冗余机制确保了数据的高可用性和可靠性。文章将从HDFS架构基础出发,详细分析其数据冗余原理、副本放置策略、故障检测与恢复机制,并通过实际案例展示这些策略在真实场景中的应用。同时,我们还将探讨HDFS冗余策略的优化方向及未来发展趋势,为大数据存储系统的设计和优化提供参考。

1. 背景介绍

1.1 目的和范围

本文旨在全面解析HDFS的数据冗余策略,包括其设计原理、实现机制和实际应用。我们将重点讨论HDFS如何通过数据冗余来保证数据的可靠性和系统的高可用性,同时也会涉及相关的性能优化策略。

1.2 预期读者

本文适合以下读者:

- 大数据开发工程师和架构师

- 分布式系统研究人员

- 云计算基础设施工程师

- 对HDFS内部机制感兴趣的技术人员

- 计算机科学相关专业的学生

1.3 文档结构概述

文章首先介绍HDFS的基本架构和数据冗余的基本概念,然后深入分析HDFS的副本策略和故障处理机制。接着通过实际案例和代码示例展示这些策略的具体实现,最后讨论优化方向和未来趋势。

1.4 术语表

1.4.1 核心术语定义

- HDFS:Hadoop Distributed File System,Hadoop分布式文件系统

- NameNode:HDFS的主节点,负责管理文件系统命名空间和客户端访问

- DataNode:HDFS的从节点,负责存储实际数据块

- Block:HDFS中的基本存储单元,默认大小为128MB

- Replication Factor:副本因子,决定每个数据块的副本数量

1.4.2 相关概念解释

- 机架感知(Rack Awareness):HDFS了解集群网络拓扑的能力,用于优化数据放置

- Pipeline复制:HDFS写入数据时采用的流水线复制机制

- 心跳机制(Heartbeat):DataNode定期向NameNode发送的信号,表明其存活状态

1.4.3 缩略词列表

- HDFS: Hadoop Distributed File System

- RPC: Remote Procedure Call

- RTT: Round-Trip Time

- SLA: Service Level Agreement

2. 核心概念与联系

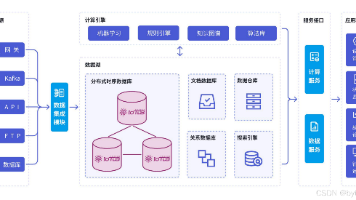

HDFS的数据冗余策略建立在几个核心概念之上,这些概念相互关联,共同构成了HDFS的高可靠性保障机制。

HDFS架构

主从结构

分块存储

数据冗余

NameNode

DataNode

Block

默认128MB

副本策略

机架感知

故障检测

默认3副本

副本放置规则

跨机架放置

网络拓扑优化

心跳检测

副本修复

HDFS采用主从架构,其中NameNode负责管理文件系统元数据,而DataNode存储实际数据块。文件被分割成固定大小的块(默认为128MB),每个块会有多个副本(默认为3个)分布在不同的DataNode上。这种设计带来了几个关键优势:

- 容错能力:单个节点故障不会导致数据丢失

- 高可用性:客户端可以从多个副本读取数据

- 负载均衡:请求可以分散到多个节点

- 并行处理:计算任务可以就近访问数据

HDFS的副本放置策略考虑了网络拓扑结构,遵循"机架感知"原则,将副本放置在不同的机架上,以防止整个机架故障导致数据不可用。

3. 核心算法原理 & 具体操作步骤

HDFS的数据冗余机制涉及多个核心算法和操作步骤,下面我们详细分析这些内容。

3.1 副本放置策略算法

HDFS的默认副本放置策略遵循以下规则(假设副本因子为3):

- 第一个副本放在客户端所在的节点(如果客户端不在集群中,则随机选择一个节点)

- 第二个副本放在与第一个副本不同机架的随机节点上

- 第三个副本放在与第二个副本相同机架的另一个节点上

这种策略实现了以下目标:

- 减少跨机架网络流量(只有第一个副本需要跨机架传输)

- 提高读取性能(可以从多个机架读取)

- 保证机架故障时的数据可用性

以下是Python实现的简化版副本放置算法:

class HDFSReplicaPlacement:

def __init__(self, cluster_topology):

"""

初始化集群拓扑结构

:param cluster_topology: 字典,表示集群拓扑 {机架1: [节点1, 节点2,...], 机架2: [...]}

"""

self.topology = cluster_topology

self.racks = list(cluster_topology.keys())

def place_replicas(self, client_node=None, replication_factor=3):

"""

决定副本放置位置

:param client_node: 客户端所在节点,如果不在集群中则为None

:param replication_factor: 副本因子

:return: 选择的节点列表

"""

replicas = []

# 第一个副本

if client_node and client_node in self._all_nodes():

replicas.append(client_node)

else:

replicas.append(self._random_node())

# 第二个副本 - 不同机架

if len(self.racks) > 1:

first_rack = self._find_rack(replicas[0])

second_rack = self._random_rack(exclude=[first_rack])

replicas.append(self._random_node(rack=second_rack))

else:

replicas.append(self._random_node(exclude=replicas))

# 剩余副本 - 尽量分散

for i in range(2, replication_factor):

placed_racks = {self._find_rack(node) for node in replicas}

# 优先选择副本数较少的机架

rack_counts = {rack: len([n for n in replicas if self._find_rack(n) == rack])

for rack in self.racks}

least_used_rack = min(rack_counts, key=rack_counts.get)

# 选择该机架上未包含当前块的节点

candidates = [n for n in self.topology[least_used_rack] if n not in replicas]

if candidates:

replicas.append(random.choice(candidates))

else:

# 如果该机架所有节点都有副本,随机选择其他节点

replicas.append(self._random_node(exclude=replicas))

return replicas

def _random_node(self, rack=None, exclude=None):

"""随机选择一个节点"""

exclude = exclude or []

if rack:

candidates = [n for n in self.topology[rack] if n not in exclude]

else:

candidates = [n for n in self._all_nodes() if n not in exclude]

return random.choice(candidates) if candidates else None

def _random_rack(self, exclude=None):

"""随机选择一个机架"""

exclude = exclude or []

candidates = [r for r in self.racks if r not in exclude]

return random.choice(candidates) if candidates else None

def _find_rack(self, node):

"""查找节点所在的机架"""

for rack, nodes in self.topology.items():

if node in nodes:

return rack

return None

def _all_nodes(self):

"""返回所有节点列表"""

return [node for nodes in self.topology.values() for node in nodes]

3.2 数据写入流程

HDFS的数据写入过程采用了流水线复制(pipeline replication)机制,具体步骤如下:

- 客户端向NameNode发起创建文件的请求

- NameNode检查权限和文件是否存在,然后返回一个数据块和副本位置列表

- 客户端建立到第一个DataNode的管道(pipeline)

- 数据被分成包(packet,默认64KB)发送

- 第一个DataNode接收数据后,将其转发给第二个DataNode,同时继续接收下一个包

- 第二个DataNode同样转发给第三个DataNode

- 每个DataNode完成写入后,会向上游节点发送确认(ack)

- 确认最终传回客户端,表示写入成功

- 完成一个块后,客户端请求NameNode分配新的块,重复上述过程

这种流水线复制方式充分利用了网络带宽,提高了写入效率。

3.3 故障检测与恢复机制

HDFS通过以下机制检测和处理故障:

- 心跳机制:DataNode定期(默认3秒)向NameNode发送心跳信号

- 块报告:DataNode定期(默认6小时)向NameNode发送其存储的所有块列表

- 副本检查:NameNode定期检查每个块的副本数量

- 故障处理:当检测到副本不足时,NameNode会启动副本复制任务

副本恢复的优先级基于以下因素:

- 副本数量严重不足的块(如只剩1个副本)

- 最近被访问的块

- 大文件比小文件优先级高

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 数据可靠性模型

HDFS的数据可靠性可以通过概率模型来分析。假设:

- 单个节点在时间t内发生故障的概率为p

- 节点故障相互独立

- 副本数量为r

- 块大小为b

那么,一个数据块在时间t内丢失的概率为:

Ploss=pr P_{\text{loss}} = p^r Ploss=pr

因为只有当所有r个副本都丢失时,数据才会真正丢失。

系统的整体数据丢失概率(假设有N个块):

Ptotal=1−(1−pr)N≈N⋅pr(当pr很小时) P_{\text{total}} = 1 – (1 – p^r)^N \approx N \cdot p^r \quad \text{(当} p^r \text{很小时)} Ptotal=1−(1−pr)N≈N⋅pr(当pr很小时)

举例说明:

- 设p=0.01(节点年故障率1%)

- r=3(默认副本数)

- N=1,000,000(100万个块)

则:

Ploss=0.013=10−6 P_{\text{loss}} = 0.01^3 = 10^{-6} Ploss=0.013=10−6

Ptotal≈106×10−6=1 P_{\text{total}} \approx 10^6 \times 10^{-6} = 1 Ptotal≈106×10−6=1

这意味着在这样的配置下,每年预期会丢失约1个数据块。

4.2 存储开销计算

副本策略带来了存储开销,计算公式为:

存储开销=实际存储空间原始数据大小=r \text{存储开销} = \frac{\text{实际存储空间}}{\text{原始数据大小}} = r 存储开销=原始数据大小实际存储空间=r

其中r是副本因子。对于默认r=3,存储开销为300%。

4.3 读取性能分析

HDFS的读取性能可以从多个方面分析:

- 就近读取:客户端优先从同一节点或同一机架的节点读取,减少网络延迟

- 并行读取:可以从多个副本同时读取不同部分

- 负载均衡:请求可以分散到多个节点

读取延迟可以建模为:

Tread=Tlocate+max(Ttransfer) T_{\text{read}} = T_{\text{locate}} + \max(T_{\text{transfer}}) Tread=Tlocate+max(Ttransfer)

其中:

- TlocateT_{\text{locate}}Tlocate 是从NameNode获取块位置的时间

- TtransferT_{\text{transfer}}Ttransfer 是从DataNode传输数据的时间

4.4 写入性能分析

流水线复制的写入时间可以近似为:

Twrite≈数据大小min(Bclient,Bnetwork)+(r−1)⋅RTT T_{\text{write}} \approx \frac{\text{数据大小}}{\min(B_{\text{client}}, B_{\text{network}})} + (r-1) \cdot \text{RTT} Twrite≈min(Bclient,Bnetwork)数据大小+(r−1)⋅RTT

其中:

- BclientB_{\text{client}}Bclient 是客户端的出口带宽

- BnetworkB_{\text{network}}Bnetwork 是网络带宽

- RTT 是往返时间

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

要实验HDFS的数据冗余策略,我们需要搭建一个Hadoop开发环境。以下是使用Docker快速搭建Hadoop集群的步骤:

- 安装Docker和Docker Compose

- 创建docker-compose.yml文件:

version: '3'

services:

namenode:

image: bde2020/hadoop-namenode:2.0.0-hadoop3.2.1-java8

container_name: namenode

ports:

- "9870:9870"

- "8020:8020"

volumes:

- namenode:/hadoop/dfs/name

environment:

- CLUSTER_NAME=hadoop-cluster

env_file:

- ./hadoop.env

datanode1:

image: bde2020/hadoop-datanode:2.0.0-hadoop3.2.1-java8

container_name: datanode1

depends_on:

- namenode

volumes:

- datanode1:/hadoop/dfs/data

env_file:

- ./hadoop.env

datanode2:

image: bde2020/hadoop-datanode:2.0.0-hadoop3.2.1-java8

container_name: datanode2

depends_on:

- namenode

volumes:

- datanode2:/hadoop/dfs/data

env_file:

- ./hadoop.env

datanode3:

image: bde2020/hadoop-datanode:2.0.0-hadoop3.2.1-java8

container_name: datanode3

depends_on:

- namenode

volumes:

- datanode3:/hadoop/dfs/data

env_file:

- ./hadoop.env

volumes:

namenode:

datanode1:

datanode2:

datanode3:

- 创建hadoop.env配置文件:

CORE_CONF_fs_defaultFS=hdfs://namenode:8020

CORE_CONF_hadoop_http_staticuser_user=root

HDFS_CONF_dfs_webhdfs_enabled=true

HDFS_CONF_dfs_permissions_enabled=false

- 启动集群:

docker-compose up -d

5.2 源代码详细实现和代码解读

我们将通过Java代码示例展示如何与HDFS交互,并检查数据冗余情况。

5.2.1 写入文件并设置副本数

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.FSDataOutputStream;

public class HDFSReplicationExample {

public static void main(String[] args) {

try {

// 1. 创建配置对象

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://namenode:8020");

// 2. 获取HDFS文件系统实例

FileSystem fs = FileSystem.get(conf);

// 3. 创建文件路径

Path filePath = new Path("/test-replication.txt");

// 4. 设置副本数为2(默认为3)

conf.setInt("dfs.replication", 2);

// 5. 创建文件并写入数据

FSDataOutputStream out = fs.create(filePath, (short)2); // 显式设置副本数

out.writeUTF("This is a test file for HDFS replication strategy.\n");

out.close();

System.out.println("File created with replication factor 2");

// 6. 获取文件块位置信息

System.out.println("Block locations:");

for(int i=0; i<fs.getFileBlockLocations(filePath, 0, Long.MAX_VALUE).length; i++) {

System.out.println("Block " + i + " locations:");

for(String location : fs.getFileBlockLocations(filePath, 0, Long.MAX_VALUE)[i].getNames()) {

System.out.println(" " + location);

}

}

fs.close();

} catch (Exception e) {

e.printStackTrace();

}

}

}

5.2.2 检查副本状态

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.BlockLocation;

public class HDFSReplicationChecker {

public static void main(String[] args) {

try {

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://namenode:8020");

FileSystem fs = FileSystem.get(conf);

Path filePath = new Path("/test-replication.txt");

if (fs.exists(filePath)) {

BlockLocation[] blockLocations = fs.getFileBlockLocations(filePath, 0, Long.MAX_VALUE);

System.out.println("File: " + filePath);

System.out.println("Block count: " + blockLocations.length);

for (int i = 0; i < blockLocations.length; i++) {

System.out.println("Block " + i + ":");

System.out.println(" Length: " + blockLocations[i].getLength() + " bytes");

System.out.println(" Replica count: " + blockLocations[i].getNames().length);

System.out.println(" Locations:");

for (String host : blockLocations[i].getNames()) {

System.out.println(" " + host);

}

}

} else {

System.out.println("File not found: " + filePath);

}

fs.close();

} catch (Exception e) {

e.printStackTrace();

}

}

}

5.3 代码解读与分析

上述代码展示了HDFS数据冗余策略的两个关键方面:

-

副本数设置:在创建文件时,可以通过

fs.create()方法的参数或配置文件设置副本数。代码中显式设置为2,低于默认值3。 -

副本位置查询:通过

getFileBlockLocations()方法可以获取每个块的副本位置信息,这对于理解HDFS的副本放置策略非常有用。

运行这些代码可以观察到:

- 文件被分成一个或多个块(取决于大小)

- 每个块有指定数量的副本(代码中为2个)

- 副本分布在不同的DataNode上

- 可以通过位置信息验证机架感知策略

在实际应用中,理解这些机制对于优化HDFS性能非常重要。例如:

- 对于不太重要的数据,可以减少副本数以节省存储空间

- 对于关键数据,可以增加副本数提高可靠性

- 通过分析副本位置可以优化计算任务的调度

6. 实际应用场景

HDFS的数据冗余策略在多种实际场景中发挥着关键作用:

6.1 大数据分析平台

在Hadoop/Spark等大数据分析平台中,HDFS的冗余策略确保了:

- 计算任务可以从最近的副本读取数据,减少网络传输

- 节点故障不会中断长时间运行的分析作业

- 数据局部性优化提高了整体处理效率

6.2 数据仓库

作为Hive等数据仓库的底层存储,HDFS的冗余策略:

- 保证了数据的高可用性

- 支持并发查询从不同副本读取

- 为ETL流程提供可靠的数据源

6.3 日志存储与分析

对于日志收集系统(如Flume、Kafka到HDFS的管道):

- 冗余策略防止日志数据丢失

- 支持高吞吐量的日志写入

- 确保日志分析系统的数据完整性

6.4 多媒体存储

存储大型媒体文件(视频、图像)时:

- 大文件分块存储提高了并行访问能力

- 冗余策略防止媒体资产丢失

- 支持流式读取和随机访问

6.5 备份与归档

作为备份存储系统:

- 内置冗余替代了传统备份软件的部分功能

- 经济高效的大规模数据存储

- 长期保存数据的可靠性

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《Hadoop权威指南》(Tom White著)

- 《HDFS原理与实践》(董西成著)

- 《Designing Data-Intensive Applications》(Martin Kleppmann著)

7.1.2 在线课程

- Coursera: “Big Data Specialization” (UC San Diego)

- edX: “Introduction to Apache Hadoop” (Linux Foundation)

- Udemy: “Hadoop Fundamentals”

7.1.3 技术博客和网站

- Apache Hadoop官方文档

- Cloudera Engineering Blog

- Hortonworks Community Connection

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- IntelliJ IDEA (优秀的Java IDE,支持Hadoop开发)

- Eclipse with Hadoop Plugin

- VS Code with Java和HDFS扩展

7.2.2 调试和性能分析工具

- HDFS fsck (文件系统检查工具)

- HDFS Balancer (平衡集群磁盘使用)

- HDFS JMX Metrics (监控HDFS状态)

7.2.3 相关框架和库

- Apache Hadoop Common

- HDFS Java API

- WebHDFS (REST接口)

7.3 相关论文著作推荐

7.3.1 经典论文

- “The Hadoop Distributed File System” (2010)

- “HDFS Architecture Guide” (Apache官方文档)

- “Google File System” (HDFS的设计灵感来源)

7.3.2 最新研究成果

- “Erasure Coding vs. Replication in HDFS” (比较纠删码和副本策略)

- “Adaptive Replication in HDFS” (动态调整副本数的研究)

- “Rack-aware Data Placement in HDFS” (机架感知优化)

7.3.3 应用案例分析

- Facebook的HDFS部署经验

- LinkedIn的HDFS扩展实践

- 阿里巴巴的HDFS优化案例

8. 总结:未来发展趋势与挑战

HDFS的数据冗余策略虽然已经相当成熟,但仍面临一些挑战和发展机遇:

8.1 纠删码(Erasure Coding)的引入

- 传统副本策略存储开销大(200-300%)

- 纠删码可提供相同可靠性,存储开销仅50-67%

- 但带来计算开销和恢复复杂性

- HDFS 3.x已支持纠删码,未来可能更广泛应用

8.2 智能副本管理

- 基于访问模式的动态副本调整

- 热点数据自动增加副本

- 冷数据减少副本或转存归档存储

8.3 混合存储架构

- 结合SSD和HDD的异构存储

- 根据数据重要性采用不同冗余策略

- 更精细的成本与性能权衡

8.4 跨数据中心冗余

- 地理分布式的数据冗余

- 支持多活数据中心场景

- 平衡延迟与可用性的挑战

8.5 与云存储的集成

- 与S3等对象存储的混合使用

- 云环境中的机架感知新定义

- 利用云服务的弹性优势

8.6 安全与隐私增强

- 加密数据的冗余策略

- 兼顾安全与性能的挑战

- 隐私保护与数据可用性的平衡

HDFS作为大数据生态系统的基石,其数据冗余策略将继续演进,以适应新的硬件架构、应用场景和业务需求。理解这些策略的原理和实现,对于设计和优化大数据存储系统至关重要。

9. 附录:常见问题与解答

Q1: HDFS默认的副本数为什么是3?可以设置为其他值吗?

A1: 默认值3是在可靠性和存储开销之间的良好折衷。可以设置为其他值(1到512之间),但需要考虑:

- 1个副本没有冗余,不推荐生产环境使用

- 增加副本数提高可靠性但增加存储成本

- 减少副本数节省空间但降低数据可靠性

Q2: 如何选择最优的副本数?

A2: 考虑以下因素:

- 数据重要性和SLA要求

- 集群规模和节点可靠性

- 存储成本预算

- 访问模式和性能需求

一般建议: - 关键数据:3-5个副本

- 普通数据:2-3个副本

- 临时/可再生的数据:1-2个副本

Q3: HDFS如何处理机架故障?

A3: HDFS的机架感知策略确保:

- 副本分布在多个机架上

- 单个机架故障不会导致数据完全不可用

- NameNode会检测故障并启动缺失副本的重新复制

Q4: 副本策略会影响读取性能吗?

A4: 是的,影响包括:

- 更多副本提供更多读取源,可能提高并行读取能力

- 机架感知策略使读取可以优先选择本地或同机架副本

- 但过多副本会增加NameNode管理开销

Q5: 如何监控HDFS的副本状态?

A5: 可以通过以下方式:

- Web UI (http://namenode:9870)

- 命令行工具:

hdfs fsck /path -files -blocks -locationshdfs dfsadmin -report

- JMX指标

- 自定义监控脚本使用HDFS API

Q6: 副本策略与纠删码(EC)如何选择?

A6: 考虑以下对比:

- 副本:实现简单,恢复快,但存储开销大

- EC:存储效率高,但恢复计算量大,适合冷数据

- 混合策略:热数据用副本,冷数据用EC

10. 扩展阅读 & 参考资料

- Apache Hadoop官方文档: https://hadoop.apache.org/docs/current/

- HDFS Architecture Guide: https://hadoop.apache.org/docs/current/hadoop-project-dist/hadoop-hdfs/HdfsDesign.html

- “The Google File System” (Sanjay Ghemawat等, 2003)

- “HDFS Erasure Coding” (Hadoop 3.x特性文档)

- “Scaling Hadoop to 4000 nodes at Yahoo!” (Yahoo!工程博客)

- “Facebook’s Hadoop Cluster” (Facebook工程博客文章)

- “HDFS Scalability: The Limitations to 4,000 Nodes” (Cloudera技术博客)

- “Rethinking Replication in HDFS” (IEEE BigData会议论文)

- “Adaptive Replication in Hadoop” (ACM SIGMOD论文)

- “A Comparative Study of Replication and Erasure Coding in HDFS” (存储系统研究论文)