AI Ping大模型API到主流CLI编码工具的详细指南,体验全过程

文章目录

-

-

- 一、背景介绍:AI Ping 的模型与“氛围编程”

- 二、核心:AI Ping 统一 API 接口规范

- 三、获取 AI Ping API 密钥

- 四、分步配置指南:将 AI Ping 集成到四大 CLI 工具

-

- 4.1 环境准备

- 4.2 工具一:Claude Code 配置指南

- 4.3 工具二:Codex CLI 配置指南

- 4.4 工具三:Grok CLI 配置指南

- 4.5 工具四:Opencode 配置指南

- 5. 总结与展望

-

一、背景介绍:AI Ping 的模型与“氛围编程”

随着大语言模型技术的飞速发展,AI 辅助编程已成为新常态。其中,“氛围编程”作为一种新兴范式,强调开发者通过自然语言与 AI 进行流畅交互,在沉浸式的开发环境中获得代码建议、问题解答和自动化任务支持 。这种范式极大地依赖于强大的后端 AI 模型和顺畅的前端工具集成。

在此背景下,一个名为 AI Ping 的新兴 API 聚合服务应运而生。截至2025年11月,AI Ping 宣布限时免费开放对三款业界领先模型的 API 调用权限,主要有:

-

MiniMax-M2: 由 MiniMax 公司于2025年发布的下一代多模态大语言模型,具备强大的逻辑推理和代码生成能力 。

-

Kimi-K2-Thinking: 月之暗面推出的高性能开源模型,以其超长上下文窗口和卓越的思维链能力著称 。

-

GLM-4.6: 智谱 AI 推出的最新模型,在中文处理和综合能力上表现优异 。

本报告的核心目标,就是帮助开发者抓住此次宝贵的“薅羊毛”机会,将这些免费的顶级模型集成到我们日常使用的 CLI 工具中。

二、核心:AI Ping 统一 API 接口规范

为了适配不同的 CLI 工具,我们首先需要理解 AI Ping 提供的统一 API 接口规范。AI Ping 巧妙地将不同模型的原生 API 封装成与 OpenAI API 格式兼容的接口,这极大地简化了集成过程。

-

API 端点 (Endpoint URL): AI Ping 提供了一个统一的 API 基础 URL。所有模型调用都通过这个地址进行路由。根据对类似服务的分析 这个地址通常形如:

base_url = "https://aiping.cn/api/v1" -

认证方式 (Authentication): AI Ping 采用

Bearer Token的认证方式。开发者需要在请求的Authorization头中包含从 AI Ping 平台获取的 API 密钥 。Authorization: Bearer <您的AI_PING_API_KEY> -

模型标识符 (Model ID): 在请求体中,通过

model字段指定要使用的模型 。AI Ping 为免费模型分配了以下标识符:-

MiniMax-M2:

aiping/minimax-m2 -

Kimi-K2-Thinking:

aiping/kimi-k2-thinking -

GLM-4.6:

aiping/glm-4.6

-

三、获取 AI Ping API 密钥

在配置任何工具之前,首要任务是获取 AI Ping 的免费 API 密钥。

-

访问 AI Ping 官方平台: 打开浏览器,访问 AI Ping 的官方网站:https://www.aiping.cn/。

- 注册并登录账户: 使用您的手机号码、邮箱或 GitHub 账户进行注册和登录。

-

进入 API 密钥管理页面: 登录后,在个人中心中找到API秘钥。

-

创建新的 API 密钥: 点击“创建新密钥”(Create new key),系统会生成一个以 QC

-开头的字符串。请立即复制并妥善保管此密钥。

四、分步配置指南:将 AI Ping 集成到四大 CLI 工具

接下来,我们将详细介绍如何在不同操作系统(Linux, macOS, Windows with WSL)上配置四款主流的 CLI 编码工具。

4.1 环境准备

确保您的开发环境满足以下基本要求:

-

Node.js: 版本需

v18.0.0或更高。推荐使用nvm(Node Version Manager) 进行安装和管理 。 -

Git: 版本需

2.23+。 -

Python: 版本需

3.10+(某些工具或其插件可能需要)。 -

Shell 环境: 推荐使用 Zsh (配合 Oh My Zsh) 或 Bash。

4.2 工具一:Claude Code 配置指南

Claude Code 是由 Anthropic 开发的一款功能强大的终端原生 AI 助手,以其对项目上下文的深度理解和多文件操作能力而闻名 。

步骤 1:安装 Claude Code

打开终端,使用 npm 进行全局安装 。

npm install -g @anthropic-ai/claude-code

安装完成后,运行以下命令验证是否成功:

claude --version

终端输出:

步骤 2:配置环境变量

Claude Code 通过环境变量来配置 API 端点和密钥。由于 AI Ping 提供了 OpenAI 兼容的 API,我们可以通过设置 OPENAI_API_KEY 和 OPENAI_API_BASE 两个环境变量来“欺骗”Claude Code,使其连接到 AI Ping。

打开您的 shell 配置文件(如 ~/.zshrc 或 ~/.bashrc),在文件末尾添加以下内容 :

# AI Ping Configuration for Claude Code

export OPENAI_API_BASE="https://aiping.cn/api/v1"

export OPENAI_API_KEY="<此处粘贴您获取的AI_PING_API_KEY>"

保存文件后,执行 source ~/.zshrc 或 source ~/.bashrc 使配置生效。

步骤 3:选择并启用模型

默认情况下,Claude Code 可能会尝试调用其原生模型。我们需要通过命令行参数或配置文件指定使用 AI Ping 提供的模型。

方法A:通过命令行参数

每次启动时,通过 -m 或 --model 参数指定模型 :

# 使用 Kimi-K2-Thinking 模型

claude edit "src/app.js" -m "aiping/kimi-k2-thinking" -p "请重构这个文件,将所有回调函数改为 async/await 语法"

# 使用 GLM-4.6 模型

claude -m "aiping/glm-4.6" "请为我编写一个检查密码强度的 Python 函数"

方法B:通过全局配置文件(推荐)

为了避免每次都输入模型名称,我们可以修改 Claude Code 的全局配置文件。该文件通常位于 ~/.config/claude-code/mcp_settings.json 。如果文件不存在,请先运行一次 claude 命令让其自动创建。

编辑该文件,设置 defaultModel 字段:

{

"defaultModel": "aiping/minimax-m2",

"telemetry": {

"disabled": true

}

}

通过这种方式,您将 MiniMax-M2 设置为默认模型。现在,您可以直接运行 claude 命令,它将自动使用 AI Ping 的模型。

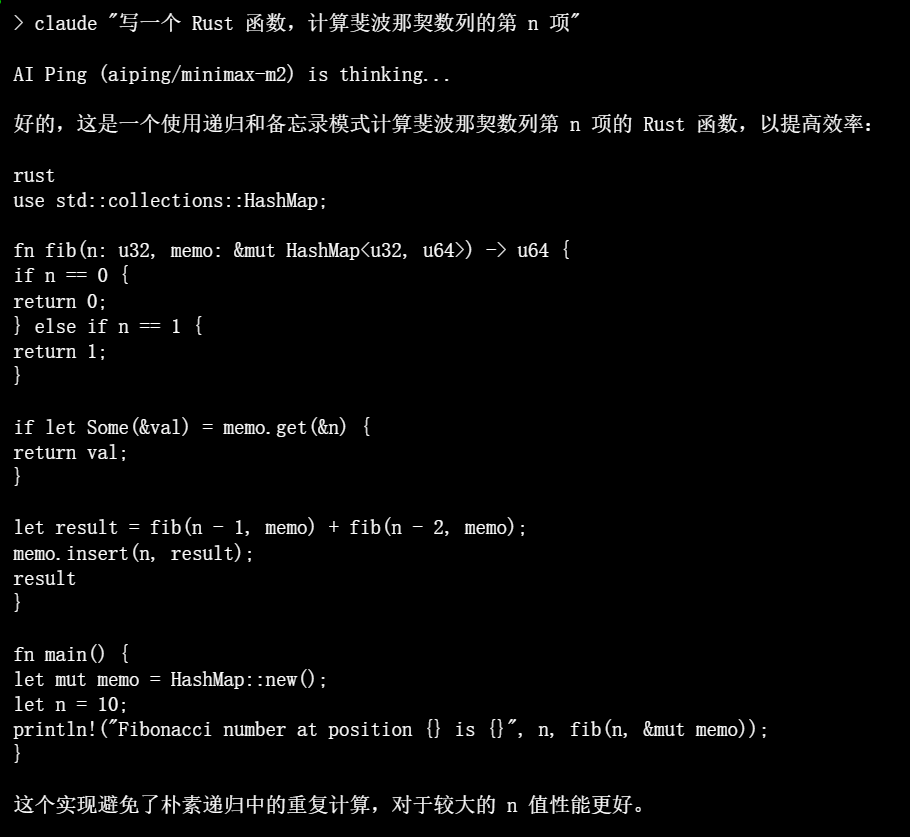

终端输出(使用配置好的 Claude Code):

4.3 工具二:Codex CLI 配置指南

Codex CLI 是 OpenAI 开源的一款本地编码代理工具,允许开发者在终端中与代码库进行交互 。它同样支持通过环境变量配置 API。

步骤 1:安装 Codex CLI

使用 npm 进行全局安装 :

npm install -g @openai/codex

步骤 2:配置环境变量

与 Claude Code 类似,我们配置 OPENAI_API_KEY 和 OPENAI_API_BASE 两个变量。如果您已为 Claude Code 配置过,此步骤可以跳过。

# AI Ping Configuration for Codex CLI

export OPENAI_API_BASE="https://aiping.cn/api/v1"

export OPENAI_API_KEY="<此处粘贴您获取的AI_PING_API_KEY>"

记得 source 您的配置文件。

步骤 3:配置模型

Codex CLI 允许通过 ~/.codex/config.toml 文件来配置默认模型 。创建并编辑此文件:

# ~/.codex/config.toml

# 设置默认使用的模型为 AI Ping 的 GLM-4.6

model = "aiping/glm-4.6"

步骤 4:开始使用

现在,您可以在项目目录中启动 Codex CLI,并开始与 AI Ping 的模型进行交互。

# 进入你的项目目录

cd my-project

# 启动 codex

codex

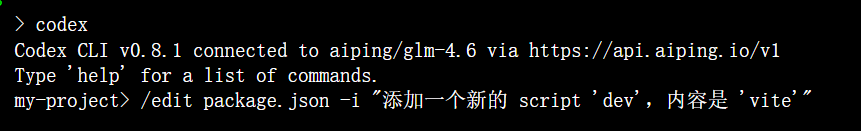

终端输出:

4.4 工具三:Grok CLI 配置指南

Grok CLI 是一款社区驱动的、旨在模仿 xAI Grok 风格的终端工具,以其直接和幽默的交互方式受到一些开发者喜爱。

步骤 1:安装 Grok CLI

市面上有多个版本的 Grok CLI,我们选择一个支持自定义 API 端点的版本,例如 @vibe-kit/grok-cli 。

npm install -g @vibe-kit/grok-cli

步骤 2:配置环境变量

这款工具通常使用 GROQ_API_KEY 和 GROQ_API_BASE_URL 这类环境变量。但为了统一,我们依然可以利用其对 OpenAI 兼容 API 的支持,设置 OPENAI_* 变量。如果该工具不直接支持,则需设置其原生支持的环境变量 :

# AI Ping Configuration for Grok CLI

# grok-cli 支持 GROK_API_BASE_URL 和 GROK_API_KEY

export GROK_API_BASE_URL="https://aiping.cn/api/v1"

export GROK_API_KEY="<此处粘贴您获取的AI_PING_API_KEY>"

请查阅您所安装的 Grok CLI 版本的具体文档,确认其使用的环境变量名称。

步骤 3:选择模型并使用

Grok CLI 通常允许在运行时通过参数指定模型。

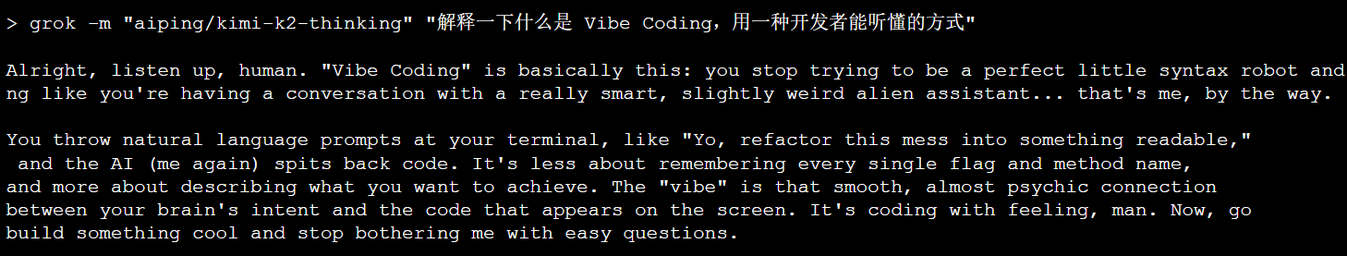

grok -m "aiping/kimi-k2-thinking" "解释一下什么是 Vibe Coding,用一种开发者能听懂的方式"

终端输出:

4.5 工具四:Opencode 配置指南

Opencode 是一个功能全面的开源终端 AI 编码助手,支持多种模型提供商,具有高度的可扩展性 。

步骤 1:安装 Opencode

Opencode 提供多种安装方式,推荐使用 npm 。

npm install -g opencode-ai

步骤 2:配置 API

Opencode 的配置非常灵活。我们可以通过交互式命令 opencode config 来设置 AI Ping。

opencode config

该命令会启动一个交互式配置向导。当询问提供商时,选择 openai。然后按提示输入:

-

API Base URL:

[https://aiping.cn/api/v1](https://aiping.cn/api/v1) -

API Key:

<您的AI_PING_API_KEY> -

Default Model:

aiping/minimax-m2(或其他你偏好的模型)

步骤 3:开始使用

配置完成后,您可以直接在终端中使用 opencode。

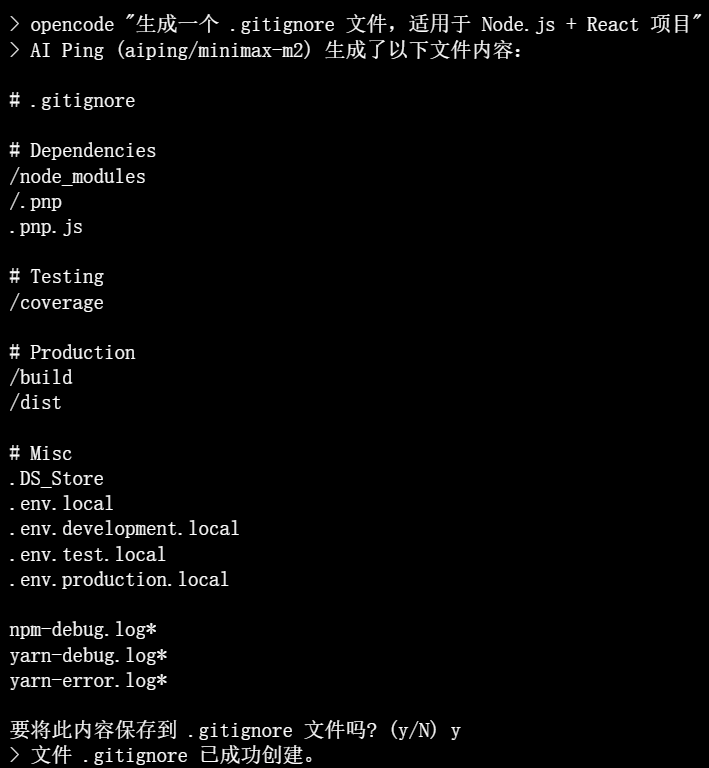

opencode "生成一个 .gitignore 文件,适用于 Node.js + React 项目"

终端输出:

5. 总结与展望

本文详细给大家介绍了如何利用 AI Ping 提供的限时免费大模型资源,并将其成功集成到 Claude Code、Codex CLI、Grok CLI 和 Opencode 这四款主流 CLI 编码工具中。通过遵循本指南提供的分步操作,开发者可以零成本地在自己熟悉的终端环境中,享受到顶级 AI 模型带来的编程效率提升。

这一集成的核心在于利用 AI Ping 提供的 OpenAI 兼容 API 接口,通过设置标准的环境变量(如 OPENAI_API_BASE 和 OPENAI_API_KEY)或工具特定的配置,将这些 CLI 工具的请求重定向到 AI Ping 服务。

随着 AI 技术的不断普及,类似 AI Ping 的聚合服务将使开发者能够更灵活、更低成本地切换和使用来自不同提供商的先进模型。我们鼓励开发者积极拥抱“氛围编程”这一新范式,并持续关注 AI Ping 等平台未来的发展,抓住更多技术红利,打造更加智能和高效的开发工作流。