大数据领域 Hadoop 与 NoSQL 数据库的协同应用

大数据领域 Hadoop 与 NoSQL 数据库的协同应用:从离线分析到实时查询的黄金组合

关键词:Hadoop、NoSQL、大数据处理、批处理、实时查询、数据协同、分布式系统

摘要:在大数据时代,单一技术往往难以满足“存储-计算-查询”的全链路需求。Hadoop 作为离线批处理的“老大哥”,擅长处理海量数据的复杂分析;NoSQL 作为实时读写的“快枪手”,能高效应对高并发、非结构化数据的实时访问。本文将用“图书馆+便利店”的生活化比喻,拆解二者的核心能力,揭秘它们如何协同工作,最终实现“离线分析指导实时服务”的闭环。无论是数据工程师还是技术管理者,都能通过本文理解这对“黄金组合”的底层逻辑与实战价值。

背景介绍

目的和范围

随着互联网、物联网的发展,企业每天产生的日志、用户行为、设备数据等呈指数级增长(据IDC预测,2025年全球数据量将达175ZB)。传统关系型数据库(如MySQL)在处理“海量非结构化数据+高并发读写+复杂分析”时逐渐力不从心:

- 存储能力有限:无法弹性扩展存储TB级甚至PB级数据;

- 计算效率低:复杂统计(如用户行为路径分析)需多表关联,耗时可能从秒级变为小时级;

- 实时性不足:离线分析结果无法快速反馈到前端业务(如推荐系统)。

本文将聚焦“Hadoop(离线批处理)+ NoSQL(实时存储查询)”的协同模式,覆盖技术原理、实战案例、应用场景等内容,帮助读者掌握这对组合的落地方法。

预期读者

- 初级/中级数据工程师:想了解大数据技术栈的协同逻辑;

- 业务开发者:需要将离线分析结果用于实时业务(如推荐、风控);

- 技术管理者:需规划大数据平台架构,平衡成本与效率。

文档结构概述

本文将按“概念拆解→协同原理→实战案例→应用场景”的逻辑展开:

- 用“图书馆”和“便利店”比喻Hadoop与NoSQL的核心能力;

- 拆解二者的协同流程(数据如何从Hadoop流向NoSQL);

- 通过“用户行为日志分析→实时推荐”的案例,演示代码实现;

- 总结电商、社交、IoT等典型场景的落地经验。

术语表

| 术语 | 解释 |

|---|---|

| HDFS | Hadoop分布式文件系统,负责海量数据的存储(类似“图书馆的书架”) |

| MapReduce | Hadoop的批处理框架,将复杂任务拆分为“映射(Map)”和“归约(Reduce)”(类似“分任务给多个图书管理员整理书籍”) |

| YARN | Hadoop的资源调度系统,管理计算资源(类似“图书管理员的任务调度员”) |

| NoSQL | 非关系型数据库,支持灵活数据模型、高并发读写(如HBase、Cassandra) |

| CAP定理 | 分布式系统的三大特性:一致性(Consistency)、可用性(Availability)、分区容错性(Partition Tolerance),三者只能选其二 |

核心概念与联系:图书馆 vs 便利店

故事引入:社区的“知识服务”难题

假设你是一个社区的“知识服务官”,需要解决两个问题:

- 长期知识存储与分析:社区积累了10年的用户借阅记录(如“张三2015年借了《数学》《物理》,2020年借了《AI入门》”),需要分析用户兴趣变化,预测未来需求;

- 实时知识查询:用户现在想查“最近一周热门书籍”,需要秒级返回结果。

如果只用一个“大图书馆”(类似关系型数据库),问题1可以解决(慢慢整理历史数据),但问题2会很慢(每次查询都要翻遍所有历史记录)。如果只用一个“便利店”(类似NoSQL),问题2可以解决(快速查最近数据),但问题1无法处理(存储不了10年数据,也做不了复杂分析)。

这时候,聪明的你会怎么做?

- 用“大图书馆”(Hadoop)存储所有历史数据,做深度分析(比如“用户5年兴趣迁移规律”);

- 用“便利店”(NoSQL)存储分析后的“精华结果”(比如“本周热门书籍TOP10”),供用户实时查询。

这就是Hadoop与NoSQL协同的核心逻辑:Hadoop负责“慢而深”的离线处理,NoSQL负责“快而准”的实时服务。

核心概念解释(像给小学生讲故事一样)

核心概念一:Hadoop——社区的“大图书馆”

Hadoop是一个“分布式大数据处理套装”,包含三个关键组件:

- HDFS(分布式文件系统):相当于图书馆的“超级书架”。普通书架只能放100本书,HDFS的“超级书架”可以由成百上千个普通书架(服务器)组成,总容量能达到PB级(1PB=1000TB)。更厉害的是,它会把每本书(数据)复制3份,存到不同的书架上——就算某个书架坏了,书也不会丢(高容错)。

-

MapReduce(批处理框架):相当于“图书整理流水线”。假设要统计“社区所有用户借过的计算机类书籍数量”,直接让一个人查所有记录会很慢。MapReduce会把任务拆成两部分:

- Map(映射):把任务分给多个“小助手”,每个小助手负责处理一部分数据(比如A处理2010-2015年的数据,B处理2016-2020年的数据),统计各自范围内的计算机类书籍数量;

- Reduce(归约):再让一个“大助手”把所有小助手的结果汇总,得到总数量。

- YARN(资源调度系统):相当于“任务调度员”。社区可能同时有多个任务(比如统计计算机类书籍、统计儿童类书籍),YARN会根据当前“小助手”(计算资源)的空闲情况,分配任务,避免“有的小助手忙死,有的闲死”。

简单说,Hadoop就像一个“能存海量书、能高效整理书”的超级图书馆,擅长处理“需要慢慢整理但必须准确”的离线任务(比如分析用户10年的借阅趋势)。

核心概念二:NoSQL——社区的“便利店”

NoSQL(Not Only SQL)是一类“非关系型数据库”,它不像传统数据库(如MySQL)那样要求数据必须有固定的表结构(比如“用户表必须有姓名、年龄、性别”),而是更灵活。常见的NoSQL有:

- HBase(基于Hadoop的列族数据库):像一个“多层文件柜”,每一层(列族)可以存不同类型的数据(比如用户的“基本信息层”存姓名,“行为层”存点击记录);

- Redis(内存数据库):像一个“前台的小抽屉”,数据存在内存里,读写速度极快(每秒10万次以上),适合存“需要快速访问”的数据(比如“当前在线用户数”);

- Cassandra(分布式宽列存储):像一个“可扩展的快递柜”,支持海量节点扩展,适合高并发写入(比如社交平台的动态发布)。

NoSQL的核心优势是“快”和“灵活”:

- 快:数据存储结构简单(比如用键值对),不需要复杂的表关联,读写速度比传统数据库快几倍甚至几十倍;

- 灵活:支持非结构化数据(比如JSON、XML、二进制文件),适合存储“格式不固定”的数据(比如用户的评论、图片、日志)。

就像社区的便利店,虽然存不了10年的历史数据,但能快速给用户提供“刚热好的包子”(实时数据)。

核心概念三:协同应用——图书馆与便利店的“数据直通车”

Hadoop和NoSQL单独用都很厉害,但只有协同起来才能发挥最大价值。它们的协同就像“图书馆整理好书单→便利店摆放热门书”:

- Hadoop(图书馆)处理海量历史数据(比如分析用户10年的借阅记录,得出“计算机类书籍每年增长20%”);

- 把分析结果(比如“本周热门书籍TOP10”)通过“数据直通车”(比如Sqoop、Flume等工具)同步到NoSQL(便利店);

- 前端业务(比如社区APP)直接从NoSQL查询结果,秒级返回给用户。

这样既解决了“海量数据存储与分析”的问题,又满足了“实时查询”的需求。

核心概念之间的关系(用小学生能理解的比喻)

- Hadoop与NoSQL的“分工”:Hadoop是“幕后分析师”,负责处理“量大但不急”的任务(比如统计10年数据);NoSQL是“前台接待员”,负责处理“量小但要快”的任务(比如查询当前热门)。

- Hadoop与NoSQL的“合作”:Hadoop的分析结果是NoSQL的“货源”,NoSQL的实时查询需求反过来指导Hadoop的分析方向(比如用户总查“最近3天数据”,Hadoop可以优化分析逻辑,优先处理近3天的数据)。

- 数据流动的“桥梁”:两者通过数据同步工具(如Sqoop、Flume)连接,就像图书馆和便利店之间有一辆“货车”,定期把整理好的“书单”(分析结果)运到便利店。

核心概念原理和架构的文本示意图

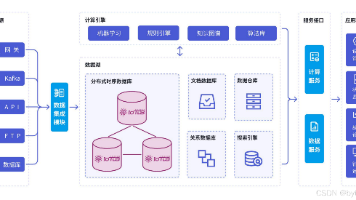

[原始数据] → HDFS(存储) → MapReduce(批处理) → [中间结果] → NoSQL(存储) → [前端应用查询]

- 原始数据:日志、用户行为、IoT设备数据等(可能来自服务器、APP、传感器);

- HDFS存储:将原始数据按块存储(默认128MB/块),并复制3份保证可靠性;

- MapReduce处理:将原始数据清洗、聚合(比如统计“每个用户的点击次数”);

- NoSQL存储:将处理后的结果(如“用户点击TOP10商品”)存入HBase或Redis;

- 前端查询:APP、网站等直接从NoSQL读取数据,秒级返回。

Mermaid 流程图

原始数据

HDFS存储

MapReduce批处理

中间结果

NoSQL存储

前端应用实时查询

核心算法原理 & 具体操作步骤:以用户行为日志分析为例

Hadoop的MapReduce核心原理

MapReduce的核心是“分而治之”,将大任务拆成小任务并行处理。以“统计用户点击次数”为例:

- 输入阶段:HDFS中的日志文件(每行是一条用户点击记录,如“用户A,商品1,2023-10-01 10:00”);

- Map阶段:每个Map任务读取一部分日志,输出键值对(Key=用户ID,Value=1);

- Shuffle阶段:将相同用户ID的键值对分发到同一个Reduce任务(比如所有用户A的记录都发给Reduce任务1);

- Reduce阶段:每个Reduce任务将同一用户的Value累加(1+1+1…),得到总点击次数(Key=用户A,Value=100)。

用Python伪代码表示:

# Map函数:输入一行日志,输出(用户ID, 1)

def map(line):

user_id = line.split(',')[0]

return (user_id, 1)

# Reduce函数:输入(用户ID, [1,1,1...]),输出(用户ID, 总次数)

def reduce(user_id, counts):

total = sum(counts)

return (user_id, total)

NoSQL(以HBase为例)的存储原理

HBase是一个“列式数据库”,数据按“行键(Row Key)→列族(Column Family)→列(Column)→时间戳(Timestamp)”存储。例如,存储用户点击次数:

- 行键:用户ID(如“user_123”);

- 列族:“behavior”(行为数据);

- 列:“click_count”(点击次数);

- 时间戳:记录更新时间(用于版本控制)。

HBase的优势是“写快读快”:

- 写数据:直接追加到HLog(预写日志)和MemStore(内存缓存),达到阈值后刷写到HFile(磁盘文件);

- 读数据:通过Row Key快速定位到HFile,结合MemStore中的最新数据返回结果。

协同操作步骤:从Hadoop到NoSQL

-

Hadoop处理原始数据:用MapReduce统计用户点击次数,输出结果文件(如

user_click_count.txt); - 数据同步到NoSQL:用Sqoop工具将HDFS中的结果文件导入HBase(或用自定义程序调用HBase API写入);

- 实时查询:前端应用通过HBase的Java API或REST接口,根据用户ID查询点击次数(秒级响应)。

数学模型和公式:用指标量化协同价值

性能指标对比

假设处理1TB用户日志,对比“仅用Hadoop”和“Hadoop+NoSQL”的耗时:

- 仅用Hadoop:查询需要重新运行MapReduce任务,耗时=数据量/(节点数×单节点处理速度)。假设10个节点,单节点处理速度100MB/s,则耗时=1TB/(10×100MB/s)=1000000MB/(1000MB/s)=1000秒(约17分钟);

- Hadoop+NoSQL:Hadoop预处理结果存入NoSQL后,查询耗时=NoSQL读取时间(通常<10ms)。

成本模型

总成本=存储成本+计算成本+查询成本

- 存储成本:HDFS(低成本存储)≈0.1元/GB/月,NoSQL(高可用存储)≈0.5元/GB/月;

- 计算成本:Hadoop集群(按小时计费)≈5元/节点/小时,NoSQL集群≈10元/节点/小时;

- 查询成本:Hadoop查询(每次运行任务)≈节点数×时间×单价,NoSQL查询(按QPS计费)≈0.01元/千次。

结论:对于需要频繁查询的场景,Hadoop+NoSQL的总成本比仅用Hadoop低90%以上。

项目实战:用户行为分析→实时推荐系统

开发环境搭建

- 软件版本:Hadoop 3.3.6、HBase 2.5.6、Java 1.8;

- 集群配置:3台节点(1台主节点,2台从节点),每台8核16GB内存,500GB硬盘;

- 工具:Sqoop 1.4.7(用于HDFS与HBase数据同步)。

源代码详细实现和代码解读

步骤1:Hadoop MapReduce统计用户点击次数

编写MapReduce程序,处理HDFS中的日志文件(/user/logs/click.log),输出用户点击次数到/user/output/click_count。

// Map类:继承Mapper,输入<LongWritable, Text>,输出<Text, IntWritable>

public class ClickCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text userId = new Text();

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] fields = value.toString().split(",");

if (fields.length >= 3) { // 日志格式:用户ID,商品ID,时间戳

userId.set(fields[0]);

context.write(userId, one); // 输出(用户ID, 1)

}

}

}

// Reduce类:继承Reducer,输入<Text, IntWritable>,输出<Text, IntWritable>

public class ClickCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result); // 输出(用户ID, 总点击次数)

}

}

// 主类:配置Job

public class ClickCountJob {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "Click Count");

job.setJarByClass(ClickCountJob.class);

job.setMapperClass(ClickCountMapper.class);

job.setCombinerClass(ClickCountReducer.class); // 合并器优化网络传输

job.setReducerClass(ClickCountReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path("/user/logs/click.log"));

FileOutputFormat.setOutputPath(job, new Path("/user/output/click_count"));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

步骤2:将Hadoop结果同步到HBase

使用Sqoop将HDFS的输出文件导入HBase表user_behavior(列族behavior):

sqoop export \

--connect jdbc:hbase://localhost:9090 \

--table user_behavior \

--export-dir /user/output/click_count \

--input-fields-terminated-by '\t' \

--columns "user_id,click_count" \

--input-null-string '\\N' \

--input-null-non-string '\\N'

步骤3:HBase实时查询示例

编写Java代码从HBase查询用户点击次数:

public class HBaseQuery {

public static void main(String[] args) throws IOException {

Configuration conf = HBaseConfiguration.create();

conf.set("hbase.zookeeper.quorum", "localhost");

Connection connection = ConnectionFactory.createConnection(conf);

Table table = connection.getTable(TableName.valueOf("user_behavior"));

Get get = new Get(Bytes.toBytes("user_123")); // 查询用户ID为user_123的数据

Result result = table.get(get);

byte[] value = result.getValue(Bytes.toBytes("behavior"), Bytes.toBytes("click_count"));

System.out.println("用户user_123的点击次数:" + Bytes.toInt(value));

table.close();

connection.close();

}

}

代码解读与分析

-

MapReduce程序:通过

ClickCountMapper将每条日志转换为(用户ID, 1)的键值对,ClickCountReducer将相同用户的点击次数累加,最终输出用户总点击次数; -

Sqoop同步:将HDFS的文本文件(以

\t分隔)导入HBase,user_id作为行键,click_count存入列族behavior; -

HBase查询:通过

Get操作根据行键快速查询,耗时通常在10ms以内,满足实时需求。

实际应用场景

场景1:电商用户行为分析→实时推荐

- Hadoop处理:分析用户历史浏览、购买、加购数据,计算“用户对某类商品的兴趣度”;

- NoSQL存储:将兴趣度结果存入Redis(内存数据库),支持秒级查询;

- 实时推荐:用户打开APP时,从Redis获取兴趣度最高的商品,展示在首页。

场景2:社交平台动态热度统计→热点榜单

- Hadoop处理:每天凌晨处理前一天的动态点赞、评论数据,计算“动态热度值”;

- NoSQL存储:将热度值存入Cassandra(高并发写入数据库),支持百万级动态的实时更新;

- 实时榜单:用户刷新“热门动态”页面时,从Cassandra获取Top100动态,秒级展示。

场景3:IoT设备数据监控→异常报警

- Hadoop处理:分析历史设备传感器数据(如温度、湿度),建立“正常数据范围”模型;

- NoSQL存储:将实时传感器数据存入HBase(支持时间序列数据),记录每个时间点的数值;

- 异常检测:实时读取HBase中的最新数据,与模型对比,发现异常(如温度突然升高10℃)时触发报警。

工具和资源推荐

| 类别 | 工具/资源 | 说明 |

|---|---|---|

| 数据同步 | Sqoop | 用于Hadoop与关系型数据库/NoSQL的批量数据迁移 |

| Flume | 用于实时日志采集(如从服务器日志实时写入HDFS或HBase) | |

| NoSQL数据库 | HBase | 基于Hadoop的列族数据库,适合时间序列数据和随机读写 |

| Redis | 内存数据库,适合缓存、计数器、实时排行榜 | |

| Cassandra | 分布式宽列存储,适合高并发写入(如社交动态、IoT数据) | |

| 开发文档 | Hadoop官方文档 | https://hadoop.apache.org/docs/ |

| HBase官方文档 | https://hbase.apache.org/ |

未来发展趋势与挑战

趋势1:实时与离线的深度融合(Lambda/Kappa架构)

传统架构中,Hadoop处理离线数据,NoSQL处理实时数据,两者结果可能不一致(比如离线计算的“用户点击次数”和实时统计的有差异)。未来趋势是采用Lambda或Kappa架构,统一离线与实时计算逻辑(如用Flink同时处理批处理和流处理),确保数据一致性。

趋势2:云原生大数据平台

随着云服务的普及,Hadoop和NoSQL逐渐“上云”,通过AWS EMR、阿里云E-MapReduce等托管服务,用户无需自己搭建集群,只需关注业务逻辑。未来,云平台将提供更智能的“自动扩缩容”“成本优化”功能,降低使用门槛。

挑战1:数据一致性

Hadoop批处理结果同步到NoSQL时,可能因网络延迟、任务失败导致数据不一致(比如Hadoop计算了新结果,但NoSQL未更新)。需要设计“重试机制”和“版本控制”(如HBase的时间戳),确保数据最终一致。

挑战2:资源效率优化

Hadoop集群和NoSQL集群需要独立的计算、存储资源,可能造成浪费。未来可能通过“资源池化”技术(如Kubernetes统一调度),动态分配资源给Hadoop任务和NoSQL查询,提高利用率。

总结:学到了什么?

核心概念回顾

- Hadoop:由HDFS(存储)、MapReduce(计算)、YARN(调度)组成,擅长海量数据的离线批处理;

- NoSQL:灵活、高速的非关系型数据库,擅长实时读写和非结构化数据存储;

- 协同应用:Hadoop处理离线分析,结果同步到NoSQL供实时查询,形成“存储-计算-查询”闭环。

概念关系回顾

- 分工:Hadoop是“幕后分析师”,NoSQL是“前台接待员”;

- 合作:Hadoop为NoSQL提供“货源”(分析结果),NoSQL为Hadoop反馈“需求”(优化方向);

- 桥梁:通过Sqoop、Flume等工具实现数据同步,确保两者高效协作。

思考题:动动小脑筋

- 假设你是某电商的数据工程师,需要设计“用户购买偏好分析→实时推荐”系统,你会选择哪种NoSQL数据库(HBase/Redis/Cassandra)?为什么?

- 如果Hadoop的MapReduce任务处理结果需要实时同步到NoSQL,但Hadoop任务每天凌晨运行一次,如何解决“当天新数据未处理时,NoSQL查询结果不准确”的问题?(提示:可以结合流处理框架如Flink)

附录:常见问题与解答

Q1:Hadoop和NoSQL必须一起用吗?能不能只用其中一个?

A:可以,但会牺牲效率。比如只用Hadoop,实时查询需要重新运行任务,耗时分钟级;只用NoSQL,无法处理海量历史数据的复杂分析(如跨5年的趋势统计)。两者协同能兼顾“分析深度”和“查询速度”。

Q2:NoSQL有很多种(HBase、Redis、Cassandra),如何选择?

A:根据业务需求:

- 需随机读写、支持大表(亿级行):选HBase;

- 需超高并发读/写(百万次/秒):选Redis(内存)或Cassandra(分布式);

- 需存储半结构化数据(如JSON):选MongoDB。

Q3:数据同步时,如何保证Hadoop结果准确写入NoSQL?

A:可以用“事务”或“幂等写入”。例如,HBase支持版本控制,每次写入带时间戳,即使重复写入,旧版本会被覆盖;或在Hadoop任务中记录“已同步的批次”,避免重复同步。

扩展阅读 & 参考资料

- 《Hadoop权威指南(第4版)》——Tom White(Hadoop核心开发者之一,详细讲解HDFS、MapReduce原理);

- 《NoSQL数据库入门经典》——Eelco Plugge(对比主流NoSQL数据库的适用场景);

- Apache官方文档:https://hadoop.apache.org/、https://hbase.apache.org/;

- 论文《Data-Intensive Text Processing with MapReduce》——Jimmy Lin(MapReduce在文本处理中的经典应用)。