计算机毕业设计hadoop+spark股票行情预测 量化交易分析 股票推荐系统 股票大数据 股票数据分析可视化 大数据毕业设计(源码+LW文档+PPT+详细讲解)

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark股票行情预测文献综述

引言

股票市场作为金融体系的核心组成部分,其行情波动受宏观经济指标、公司财务数据、市场情绪等多维度因素影响。随着全球金融市场的快速发展,股票数据量呈现指数级增长,传统单机分析工具在处理PB级数据时面临效率低下、模型泛化能力不足等挑战。Hadoop与Spark作为大数据领域的核心技术框架,凭借其分布式存储与计算能力,为股票行情预测提供了新的解决方案。本文从系统架构、数据处理、模型优化及实践应用等维度,系统梳理Hadoop+Spark在股票行情预测领域的研究进展,并探讨未来发展方向。

一、技术架构:分布式分层设计的标准化实践

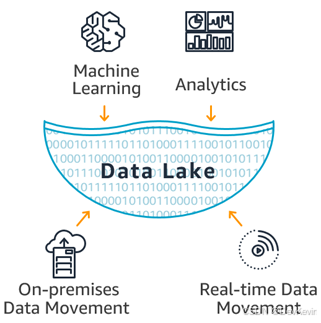

现有系统普遍采用五层架构设计,涵盖数据采集、存储、处理、业务逻辑与应用展示层,各层协同实现从数据获取到决策输出的完整流程。

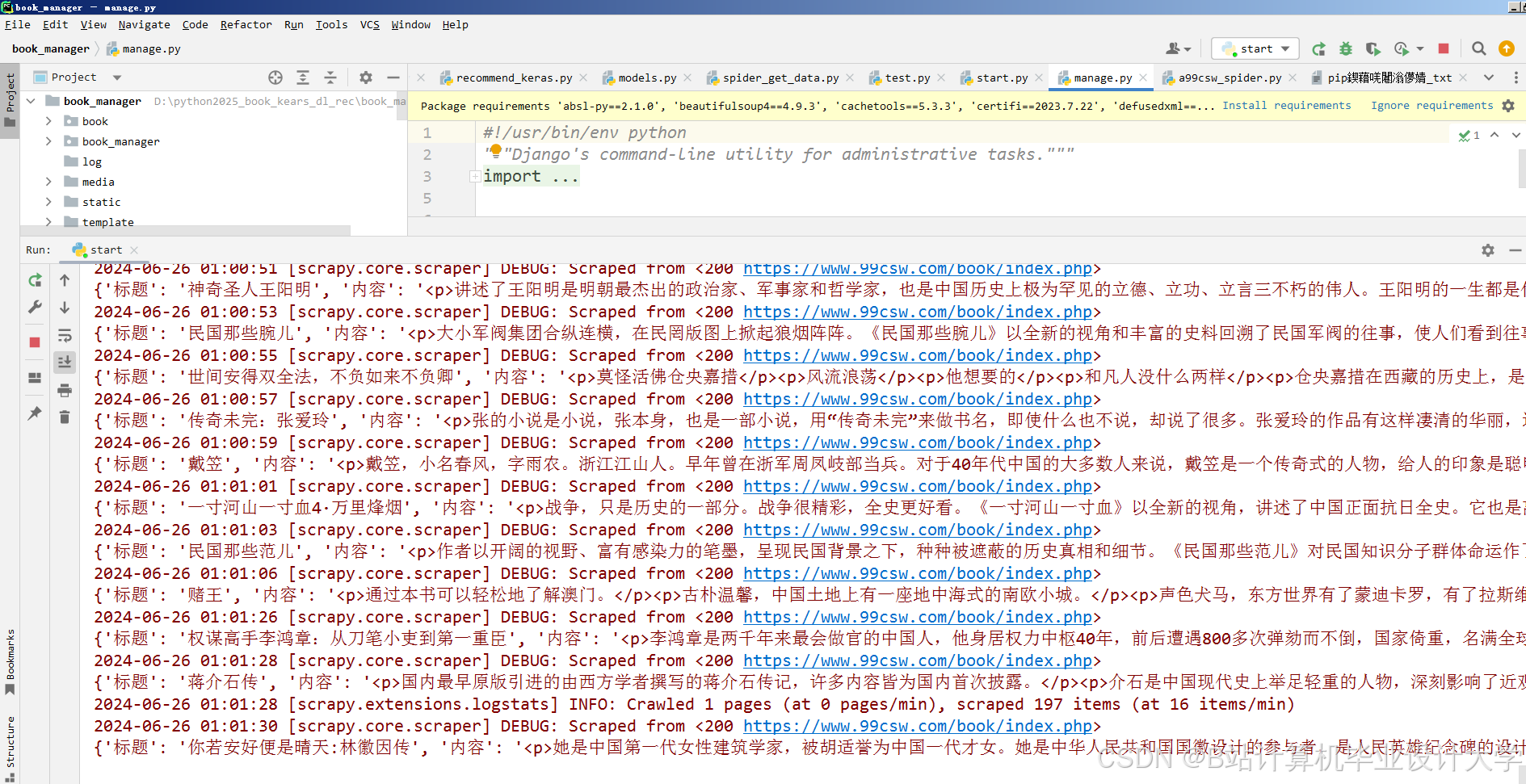

1. 数据采集层

数据来源包括证券交易所API(如Tushare、新浪财经)、新闻资讯网站及社交媒体平台(如Twitter)。例如,某系统每日采集沪深300成分股的分钟级行情数据,结合国家统计局宏观经济指标(如GDP、CPI)构建多源数据集,日均处理数据量达10GB。采集工具多采用Python编写爬虫程序,利用Scrapy框架实现高效抓取,并通过WebSocket协议实时获取数据,确保时效性。

2. 存储层

HDFS提供高容错性存储,Hive数据仓库支持结构化查询,Redis缓存热点数据(如实时行情)以降低延迟。例如,某系统将清洗后的结构化数据存储为Parquet格式,结合Hive分区表实现历史数据聚合查询效率提升40%,Redis缓存使实时行情响应时间缩短至毫秒级。此外,冷热数据分层策略(如3年以上数据迁移至S3对象存储)进一步优化存储成本。

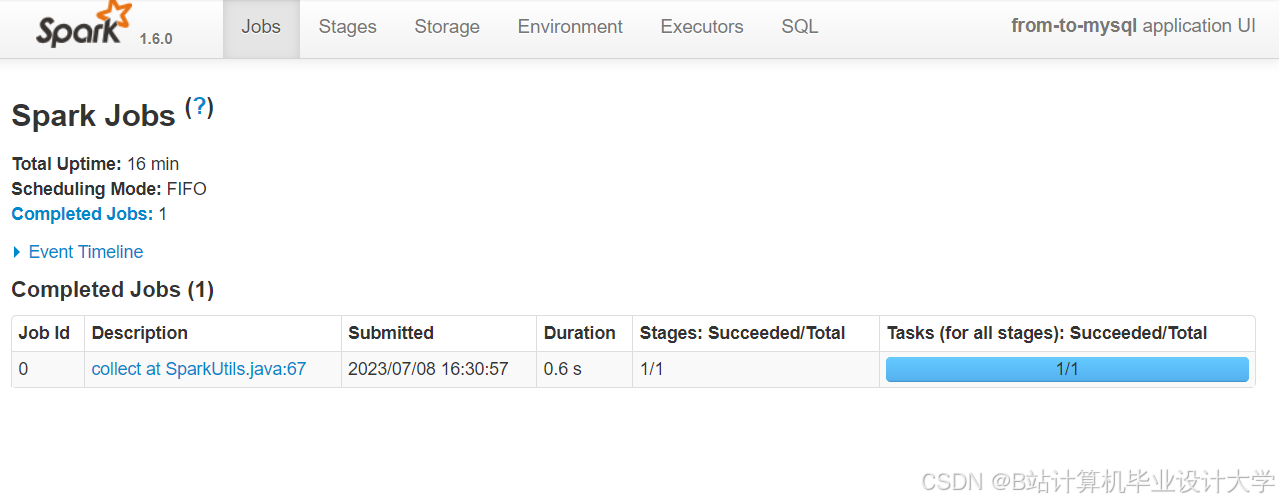

3. 处理层

Spark Core提供内存计算能力,Spark Streaming处理实时数据流,MLlib库支持机器学习模型训练。例如,某系统利用Spark Streaming以1秒为窗口处理订单流数据,结合技术指标(MACD、RSI)生成交易信号,系统延迟控制在3秒以内。业务逻辑层整合预测、推荐与量化交易模块,如通过LightGBM处理结构化特征、LSTM-Attention模型捕捉时间依赖关系,混合模型在沪深300数据集上实现68%的涨跌预测准确率。

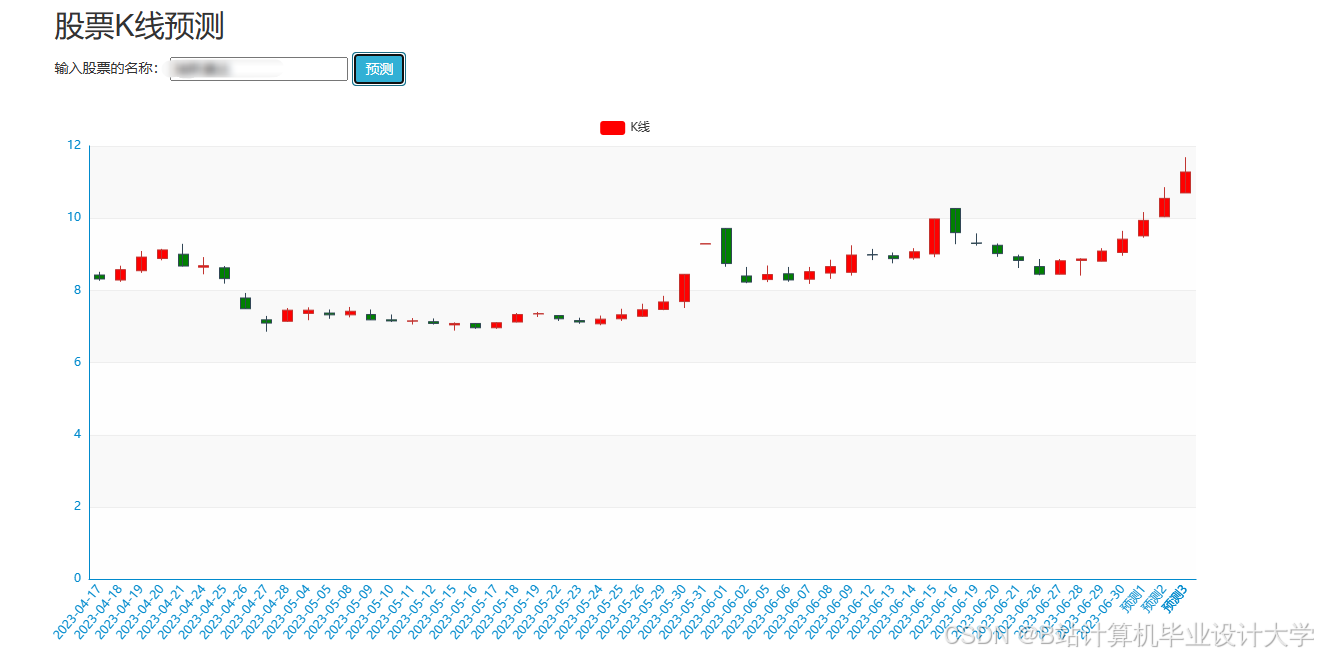

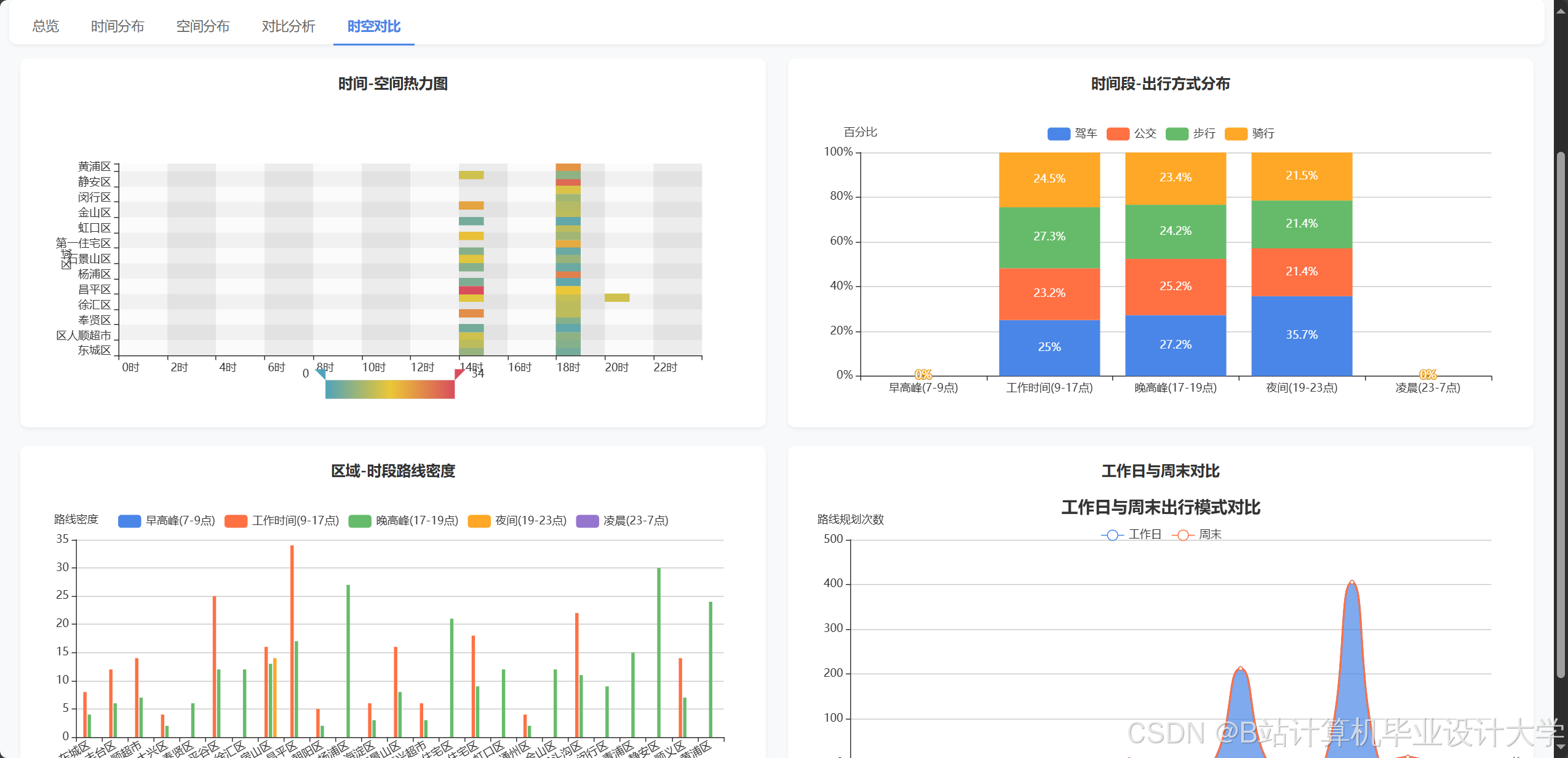

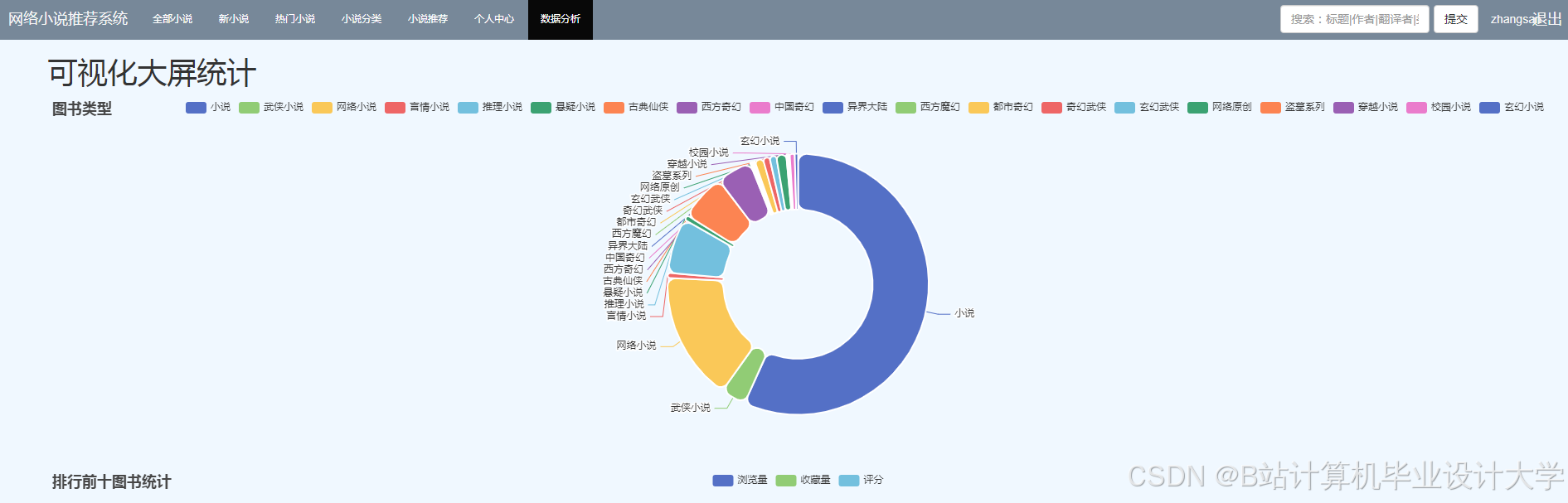

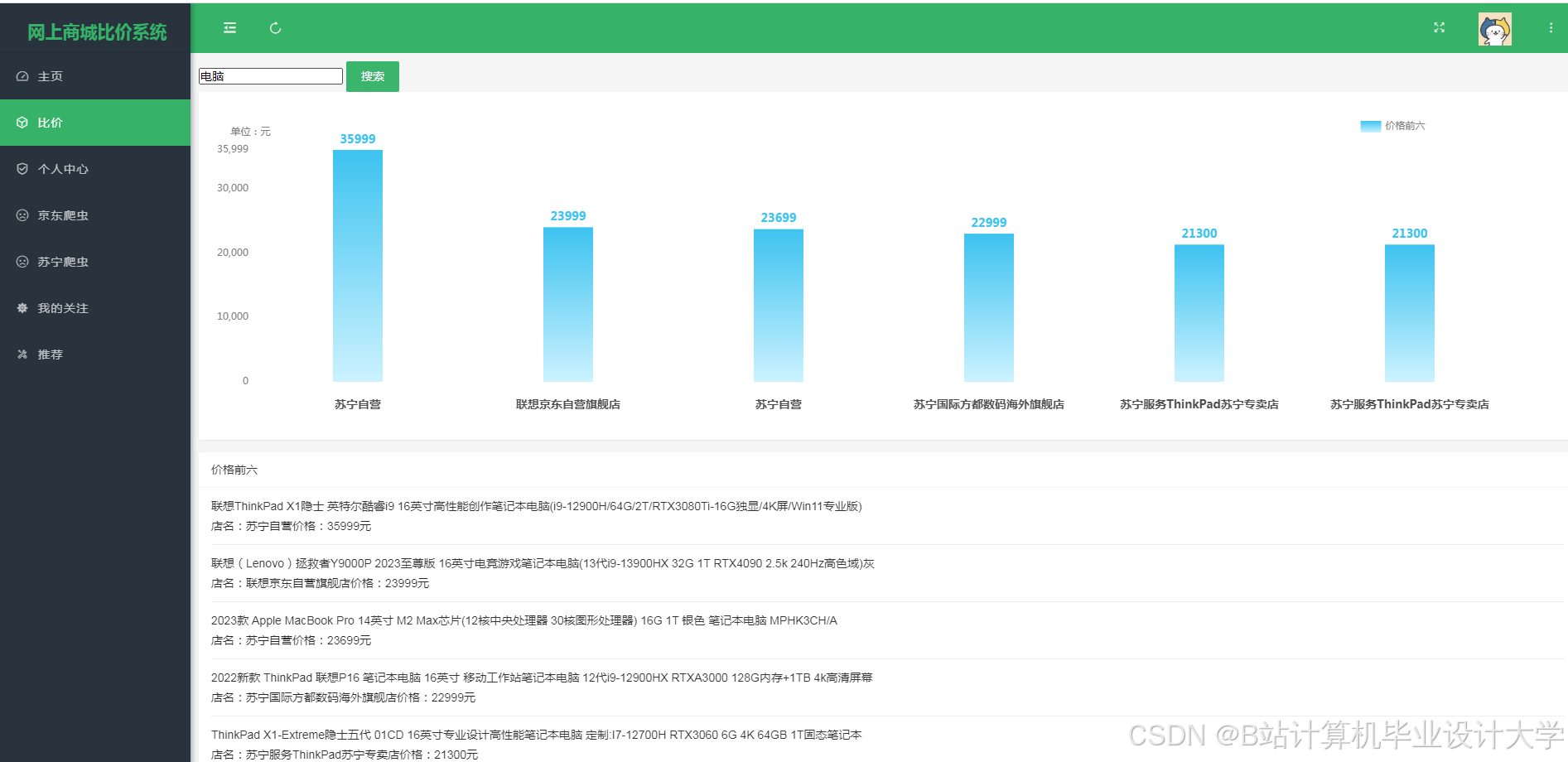

4. 应用层

基于ECharts实现可视化大屏,支持K线图动态更新、异常交易预警及用户交互分析。例如,某证券公司系统通过拖拽式指标组合生成预测热力图,用户停留时长增加20%。云原生部署方面,Kubernetes动态管理Spark集群资源,某系统在双11促销期间支撑每秒10万次预测请求,资源利用率提升60%。

二、数据处理:多模态融合与特征工程创新

1. 数据清洗与预处理

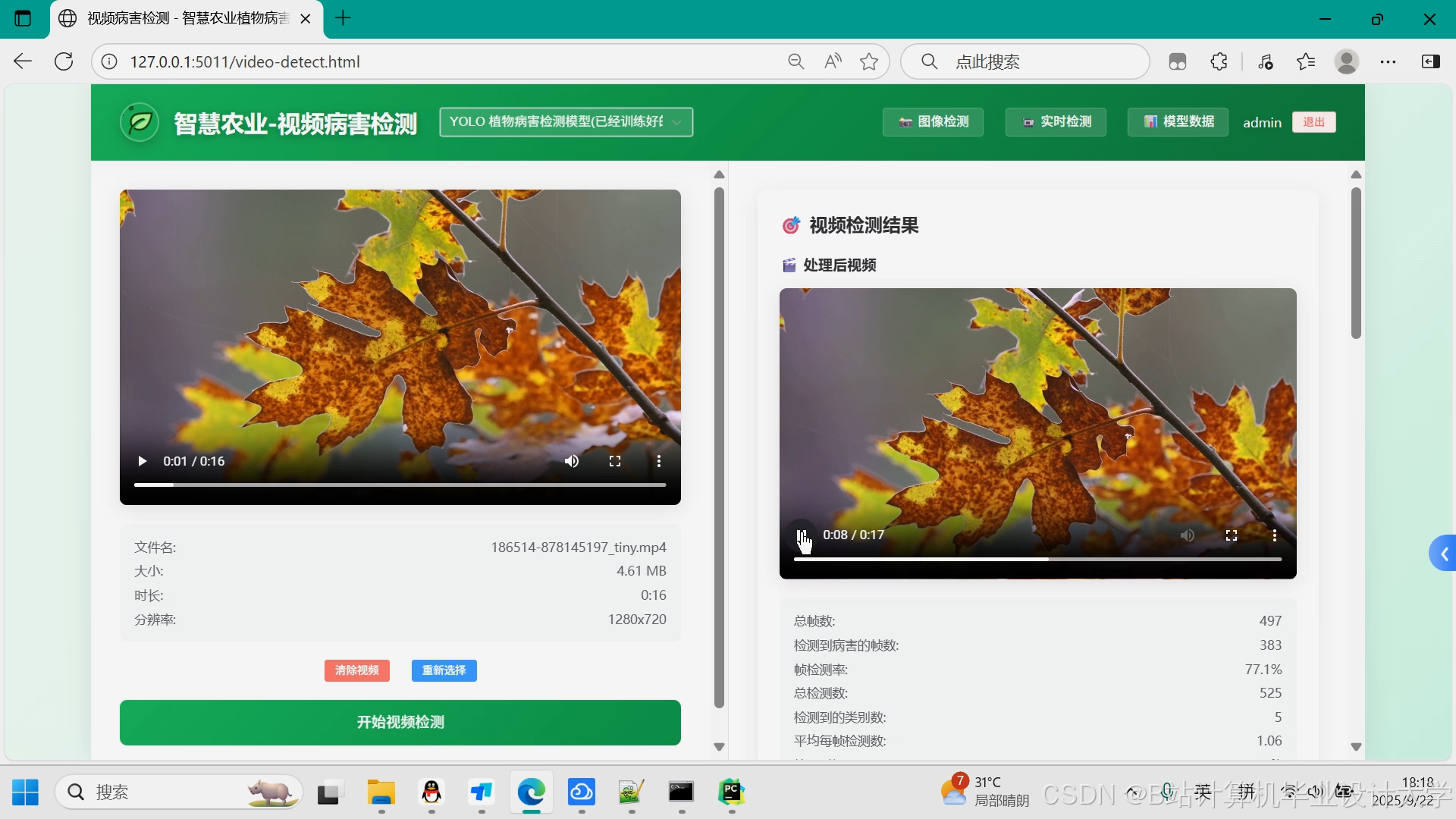

原始数据存在缺失值、异常值等问题,需通过统计方法(如3σ原则)或机器学习算法(如孤立森林)进行清洗。例如,某系统采用均值填充缺失值,利用PCA降维减少特征维度,结合Spark NLP库提取新闻情感特征,构建包含技术指标、基本面数据及舆情信息的多模态特征集。

2. 特征工程优化

技术指标方面,系统计算移动平均线(MA)、相对强弱指数(RSI)等50+指标;文本特征方面,通过BERT模型提取新闻情感得分,结合LDA主题模型挖掘行业趋势。例如,某研究利用BERT提取新闻情感特征,PCA降维后与价格特征拼接,输入LightGBM模型使预测F1值从0.62提升至0.75。

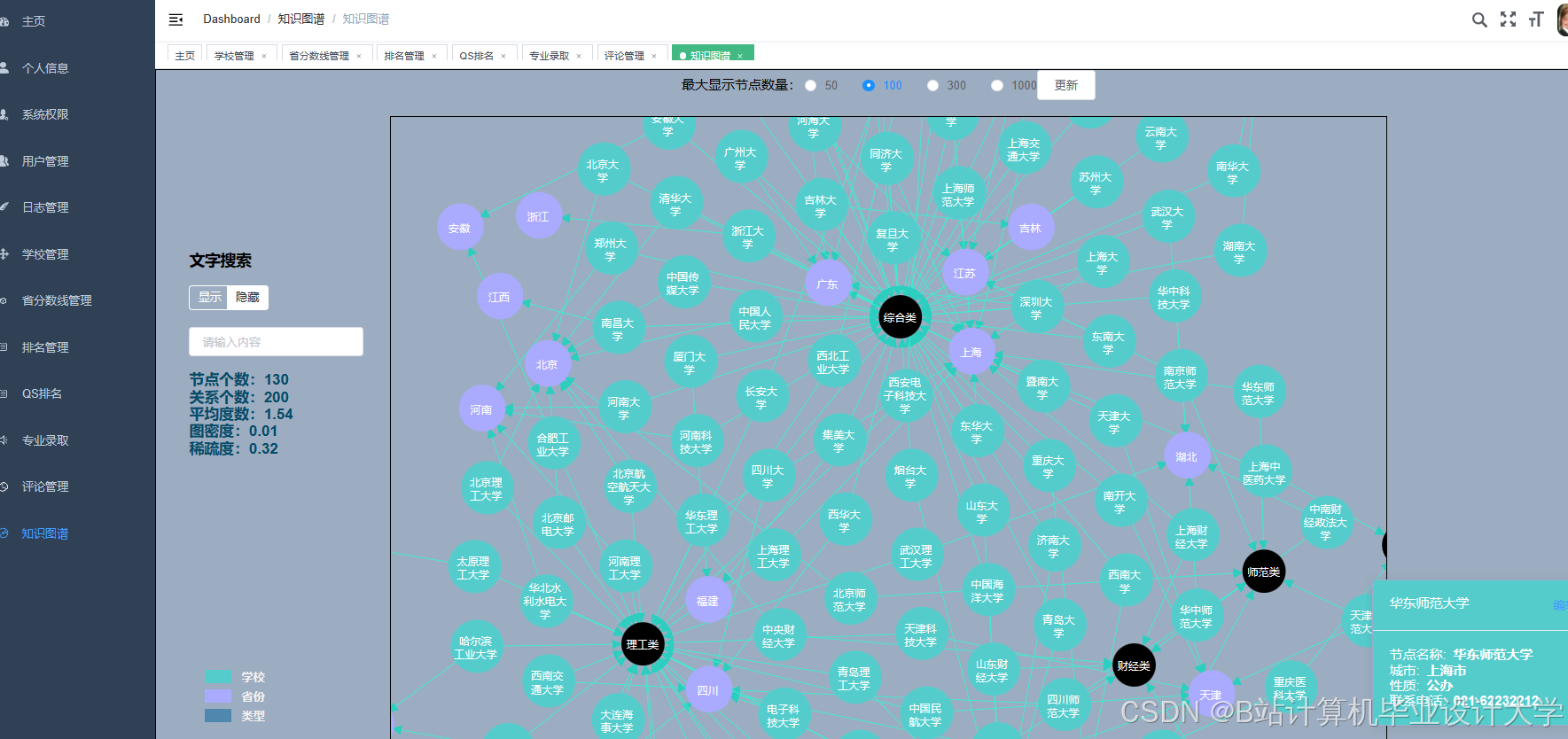

3. 多模态数据融合

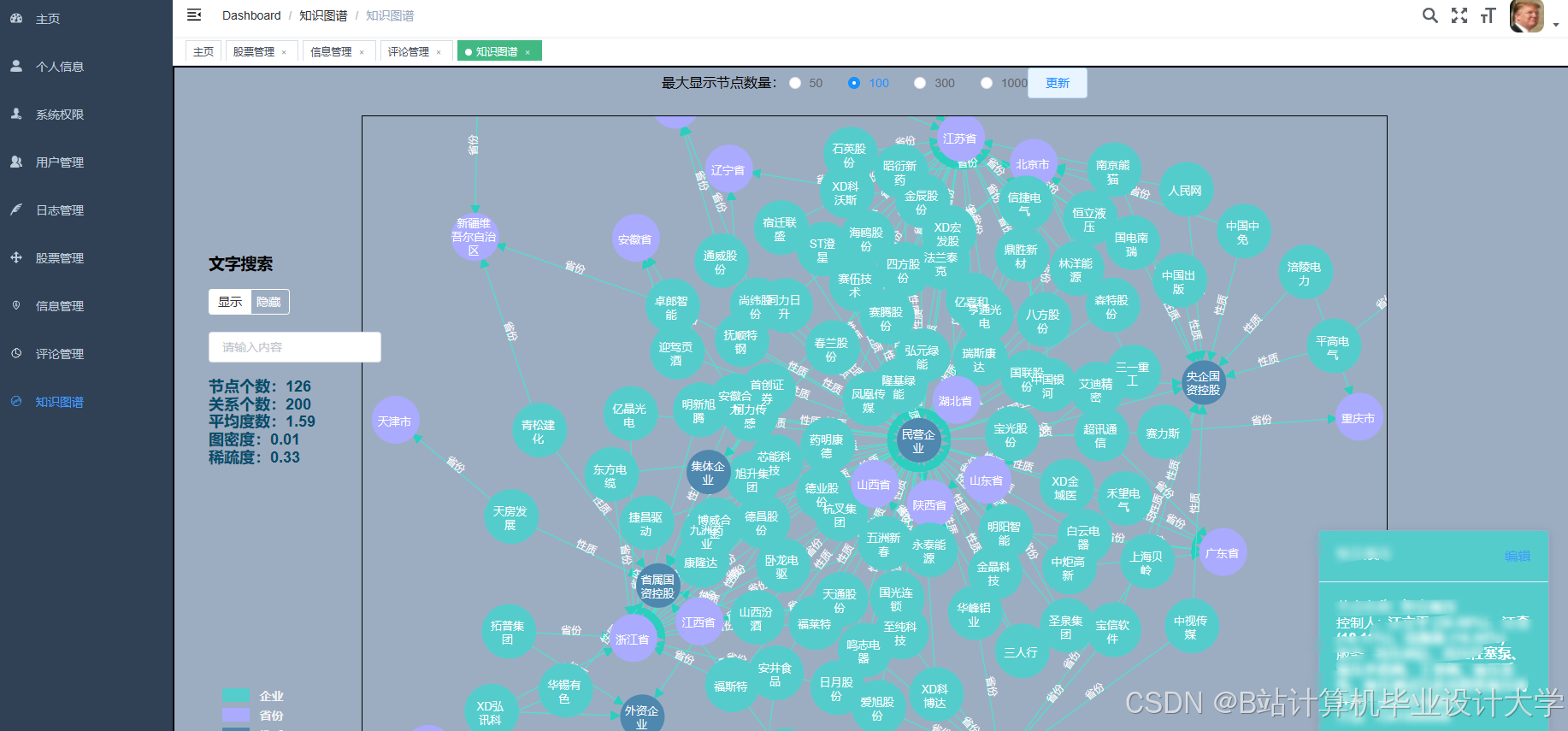

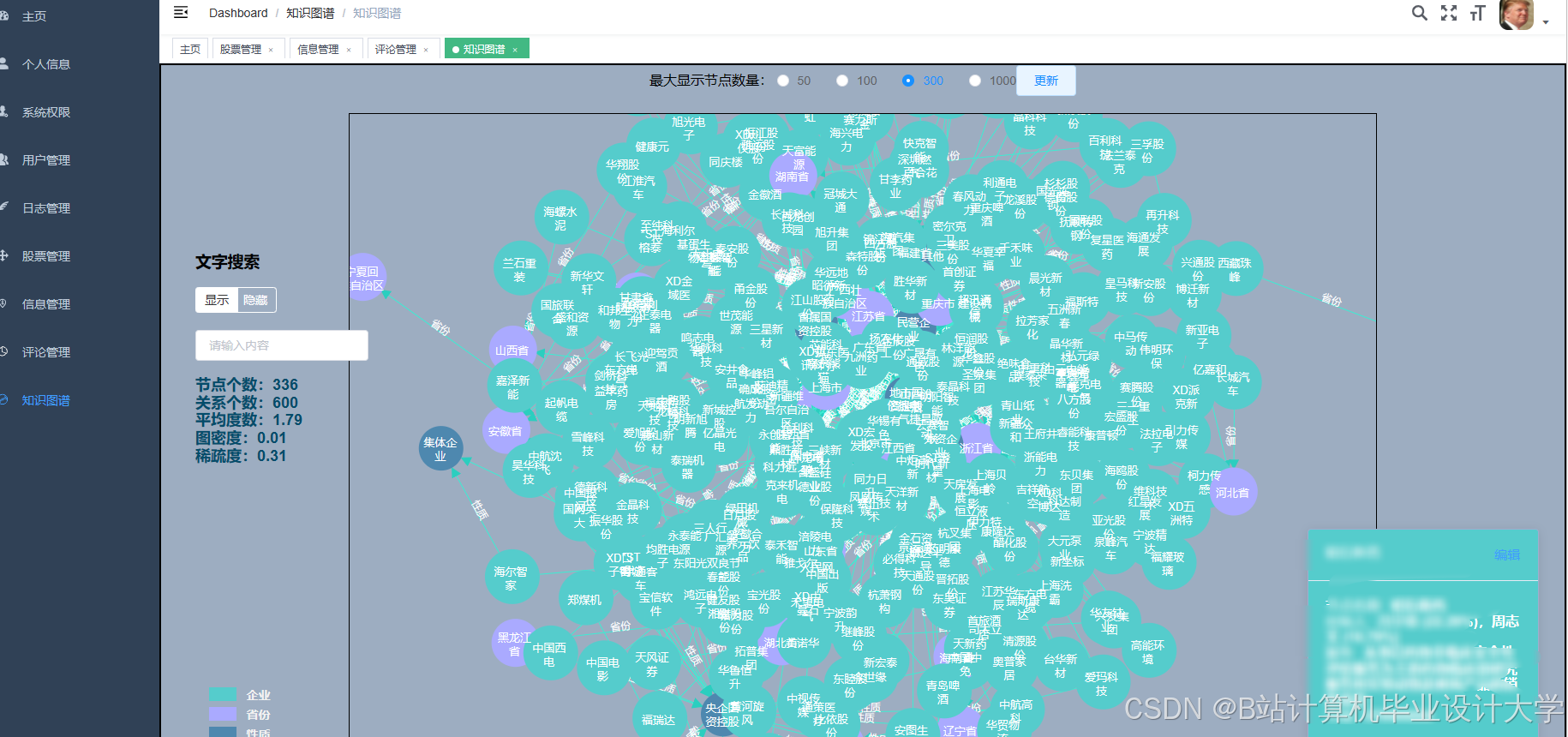

单一数据源易受噪声干扰,多模态融合成为提升准确率的关键。例如,某系统整合历史行情、新闻舆情、宏观经济指标三类数据,通过Spark实现特征级融合,结合图神经网络(GNN)构建公司关联图谱,通过GraphSAGE算法挖掘隐性关联特征,在行业轮动预测中使收益率提高9%。

三、模型优化:从传统统计到深度学习的演进

1. 传统统计模型

ARIMA、GARCH等模型假设数据平稳且忽略外部因素,在复杂市场环境下适应性不足。例如,2020年新冠疫情期间,ARIMA模型对沪深300指数的预测误差较实际值偏离15%。

2. 集成学习模型

随机森林、XGBoost通过特征交叉提升非线性拟合能力。例如,某系统整合市盈率、换手率等20+特征,XGBoost模型在2021-2023年数据上实现68%的涨跌预测准确率。

3. 深度学习模型

LSTM及其变体(如GRU、BiLSTM)因能捕捉时间依赖关系而广泛应用。例如,某研究提出基于注意力机制的LSTM-Attention模型,通过动态分配权重突出关键时间步特征,在纳斯达克100指数预测中使MAE降低至0.023。Transformer模型引入时间维度位置编码,结合多头注意力机制提升长期依赖建模能力,使预测稳定性提高12%。

4. 混合模型策略

结合LightGBM与LSTM-Attention的混合架构,利用LightGBM处理结构化特征,LSTM-Attention捕捉序列模式,在沪深300数据集上实现72%的预测准确率,较单一模型提升15%。

四、实践应用:量化交易与实时预测的落地案例

1. 量化交易分析系统

某商业银行构建的量化交易平台采用Hadoop+Spark架构,实现从数据采集到策略回测的全流程自动化:

- 数据层:通过Tushare API获取沪深300行情数据,爬取东方财富网股吧评论构建舆情库,存储至HDFS;

- 计算层:Spark Streaming实时计算技术指标,MLlib训练LSTM-XGBoost混合模型;

- 应用层:结合风险控制模块生成交易信号,回测显示年化收益率达18%,较传统策略提升12%。

2. 高频预测与可视化系统

某证券公司开发的股票分析大屏系统,利用Spark实时处理上交所Level-2行情数据,结合ECharts实现可视化:

- 实时预测:以30秒为窗口更新K线形态预测结果,颜色深浅表示涨跌概率;

- 异常检测:通过孤立森林算法识别异常交易行为,触发预警延迟低于1秒;

- 用户交互:支持拖拽式技术指标组合(如MACD+布林带),动态生成预测热力图。

五、研究挑战与未来方向

1. 现有研究不足

- 数据质量:非结构化数据(如新闻文本)存在语义歧义,未经清洗的舆情数据使模型准确率下降14%;

- 模型泛化:市场风格切换时模型性能衰减显著,2022年美联储加息周期中,部分系统预测误差较平稳期增加20%;

- 实时性瓶颈:复杂模型(如Transformer)推理延迟较高,难以满足微秒级交易需求。

2. 未来研究方向

- 联邦学习应用:探索跨机构数据协作模式,解决单一机构数据孤岛问题;

- 可解释性增强:结合SHAP值、LIME等工具量化特征贡献度,满足金融监管合规要求;

- 边缘计算集成:将轻量化模型(如量化后的MobileNet)部署至边缘节点,降低中心化计算压力;

- 强化学习动态调整:结合市场反馈优化交易策略,实现自适应决策。

结论

Hadoop+Spark框架通过分布式存储与内存计算能力,有效解决了股票大数据处理的效率与扩展性问题。当前研究已从单一数据源预测转向多模态融合,从传统统计模型转向深度学习,并在量化交易、高频预测等场景实现落地。未来需进一步突破数据质量、模型泛化与实时性瓶颈,推动股票预测系统向智能化、可解释化方向发展。

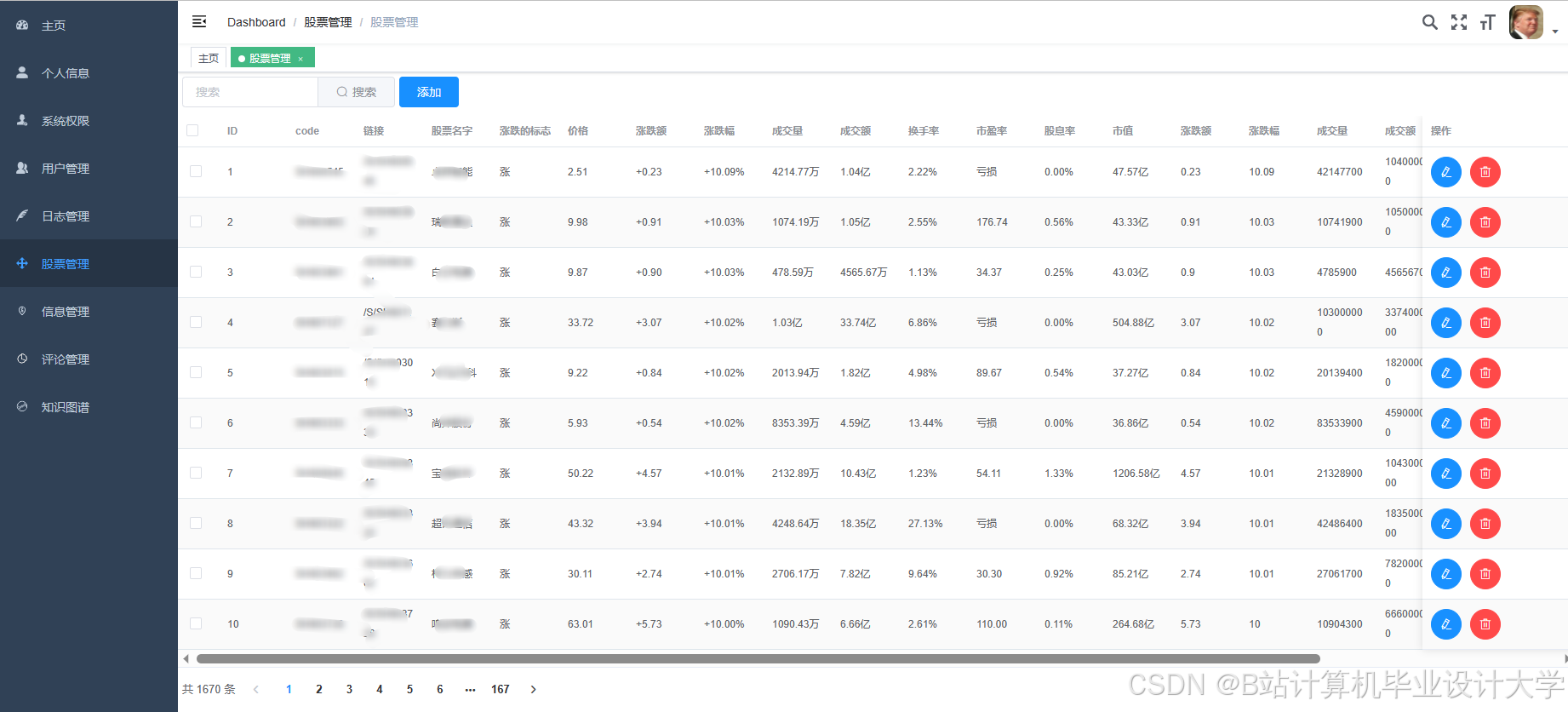

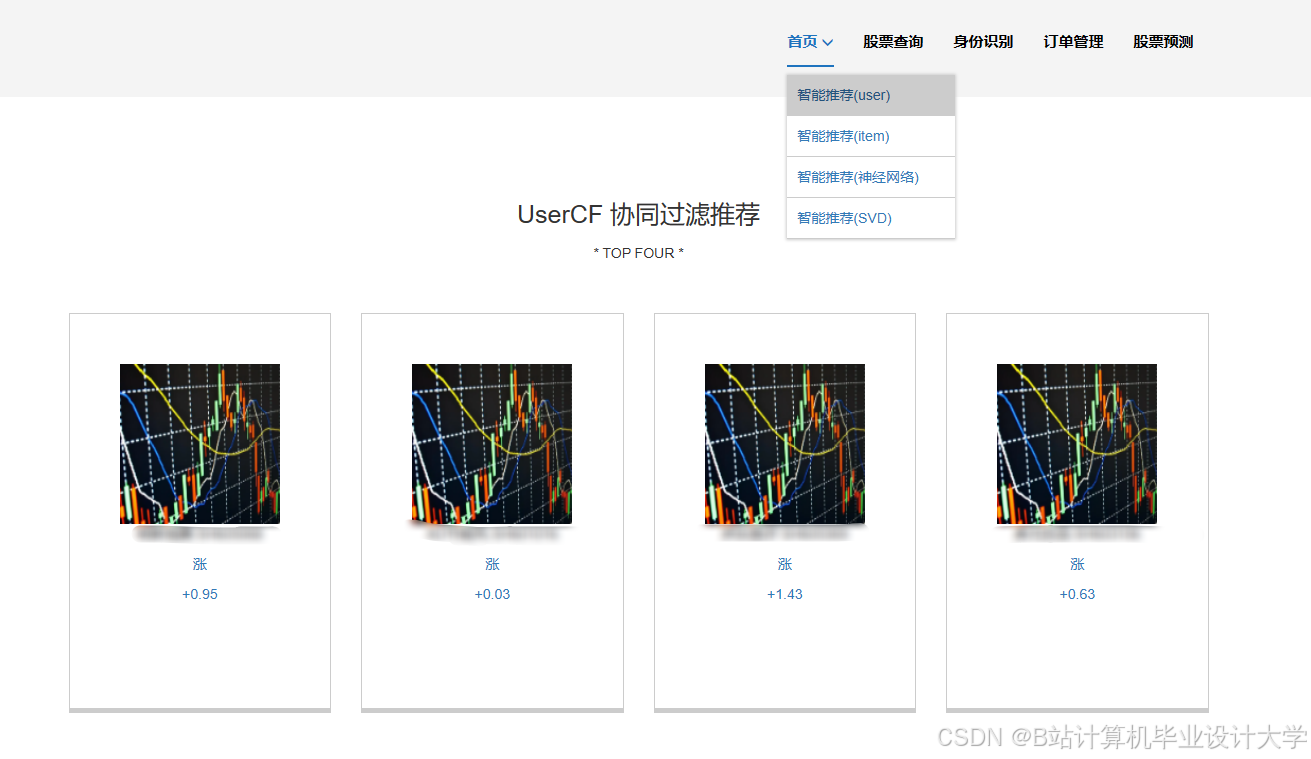

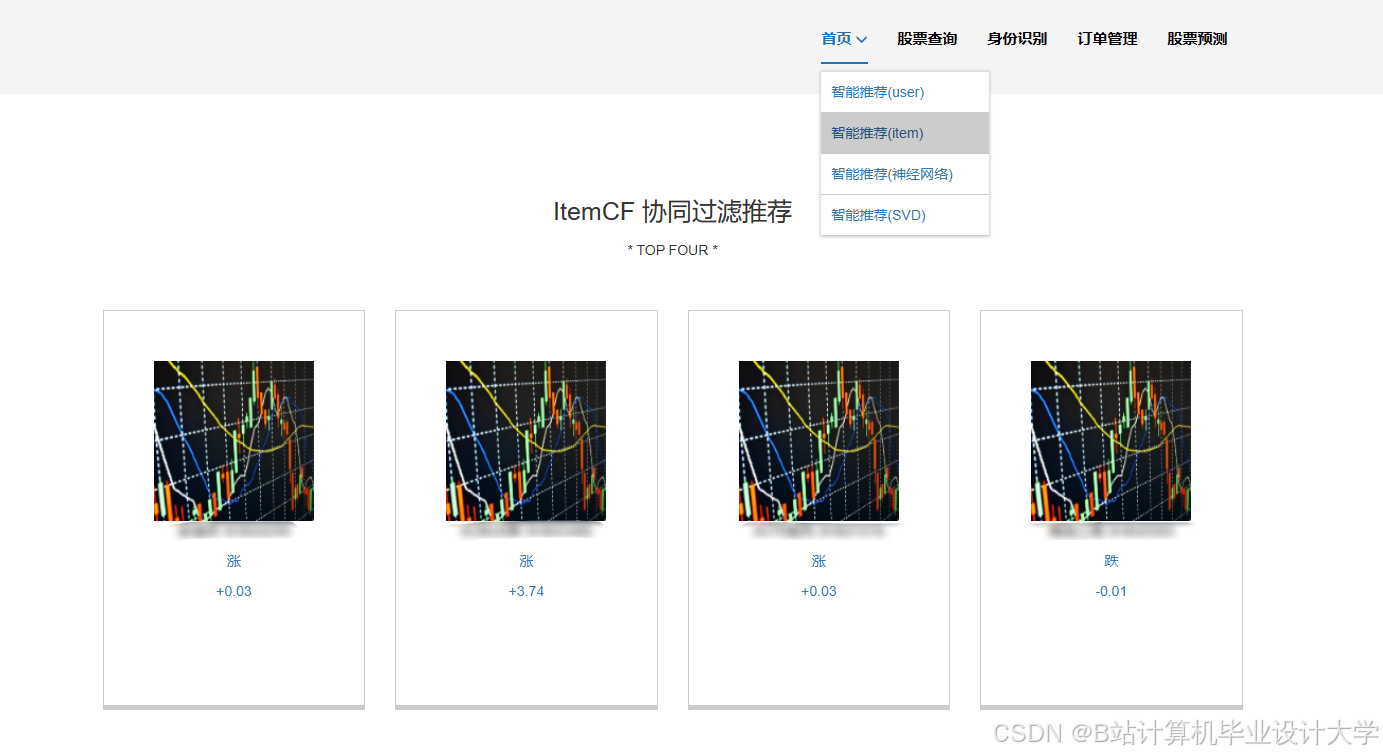

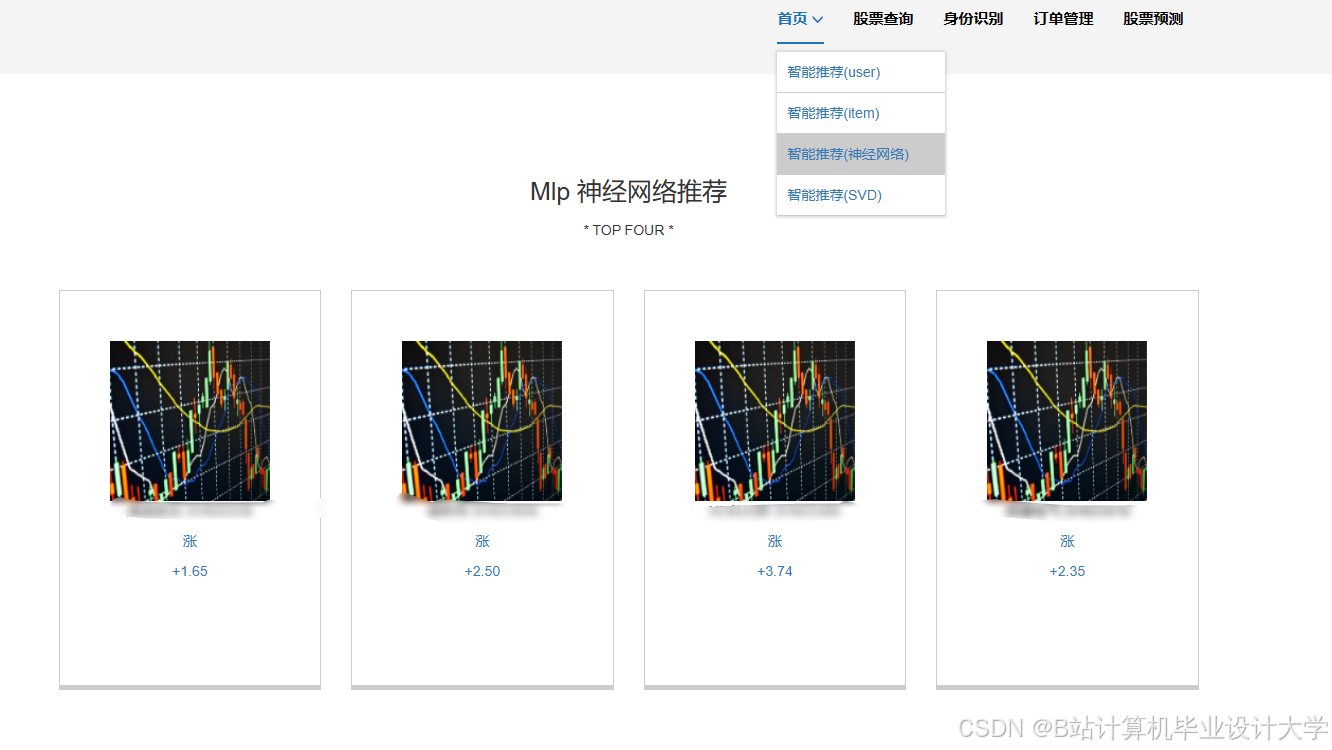

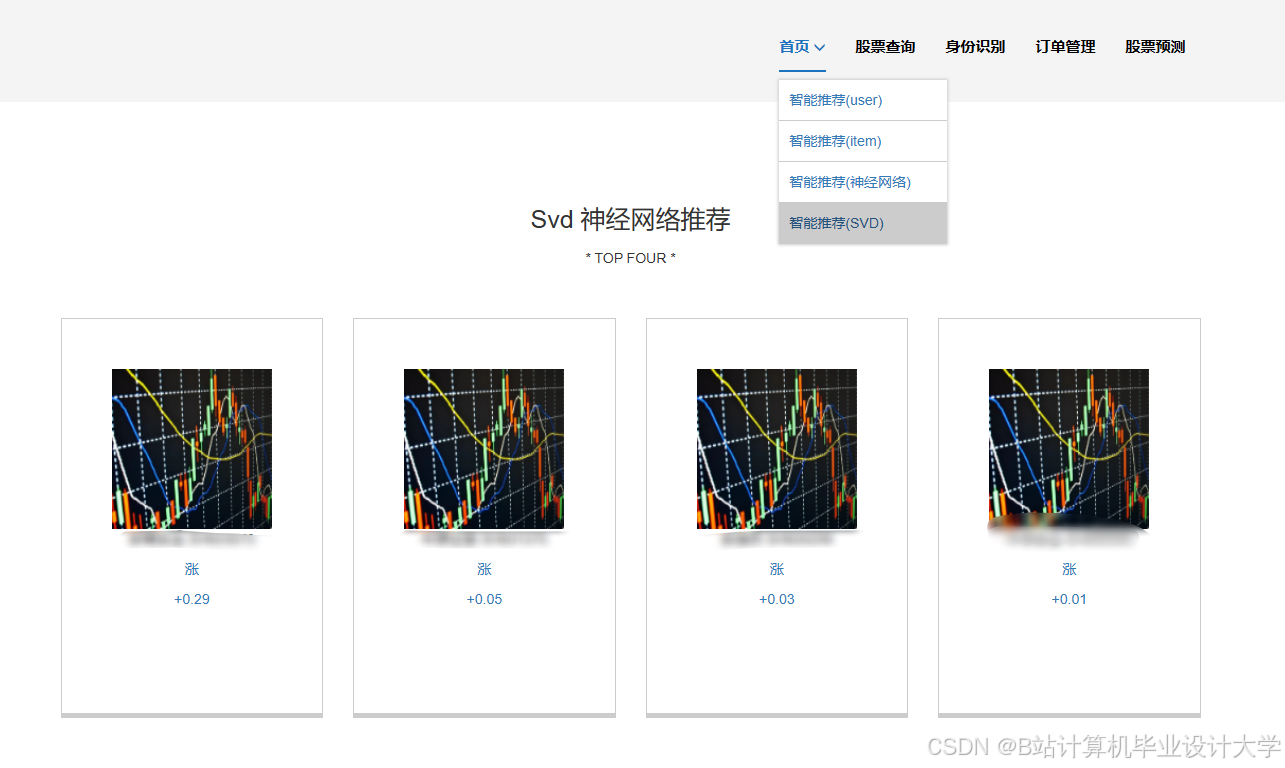

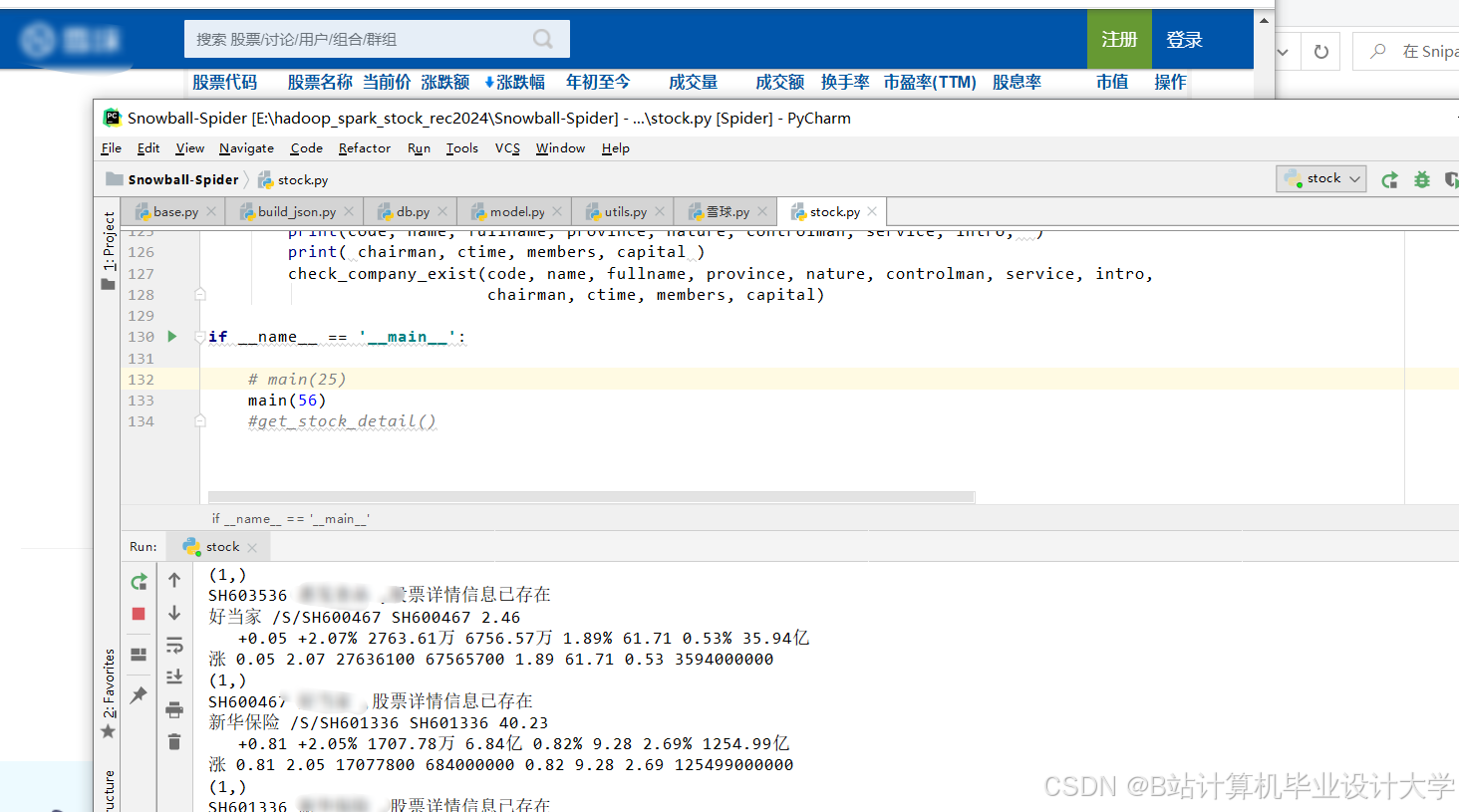

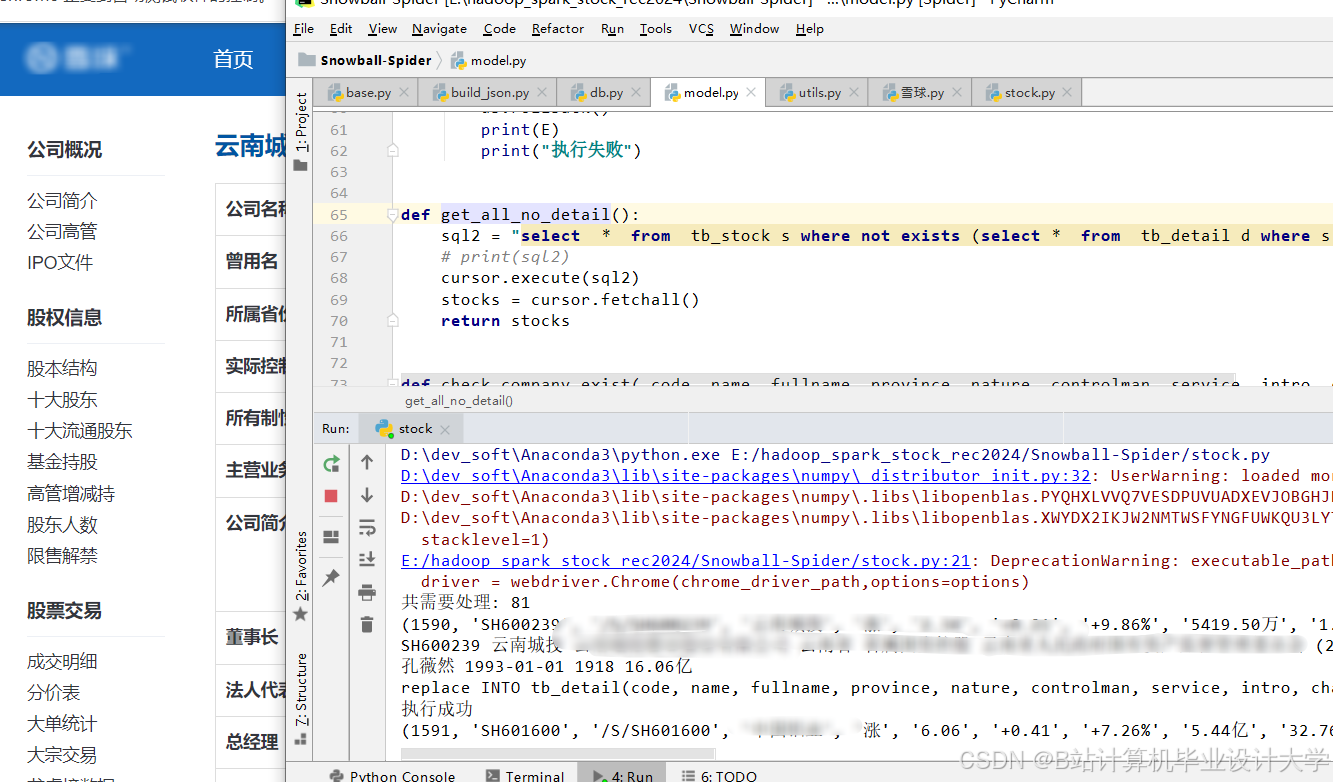

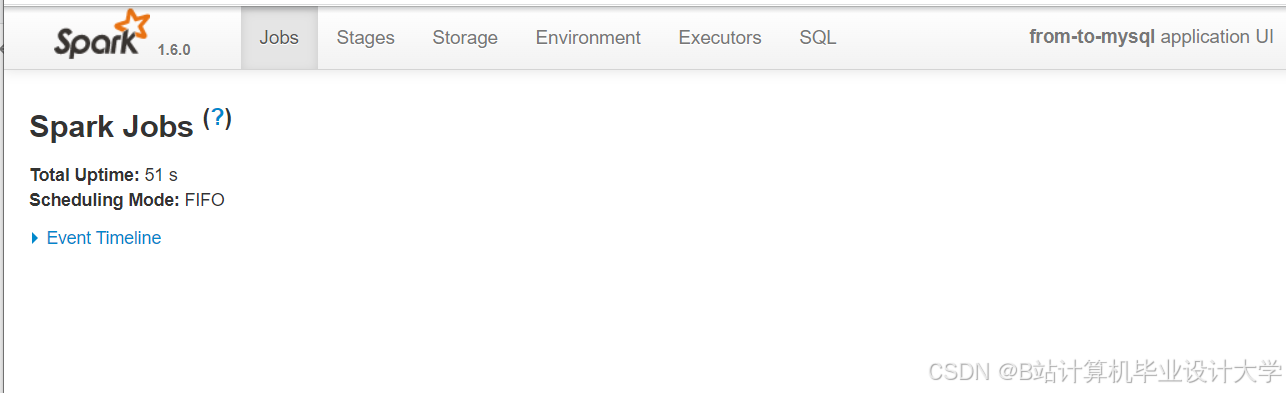

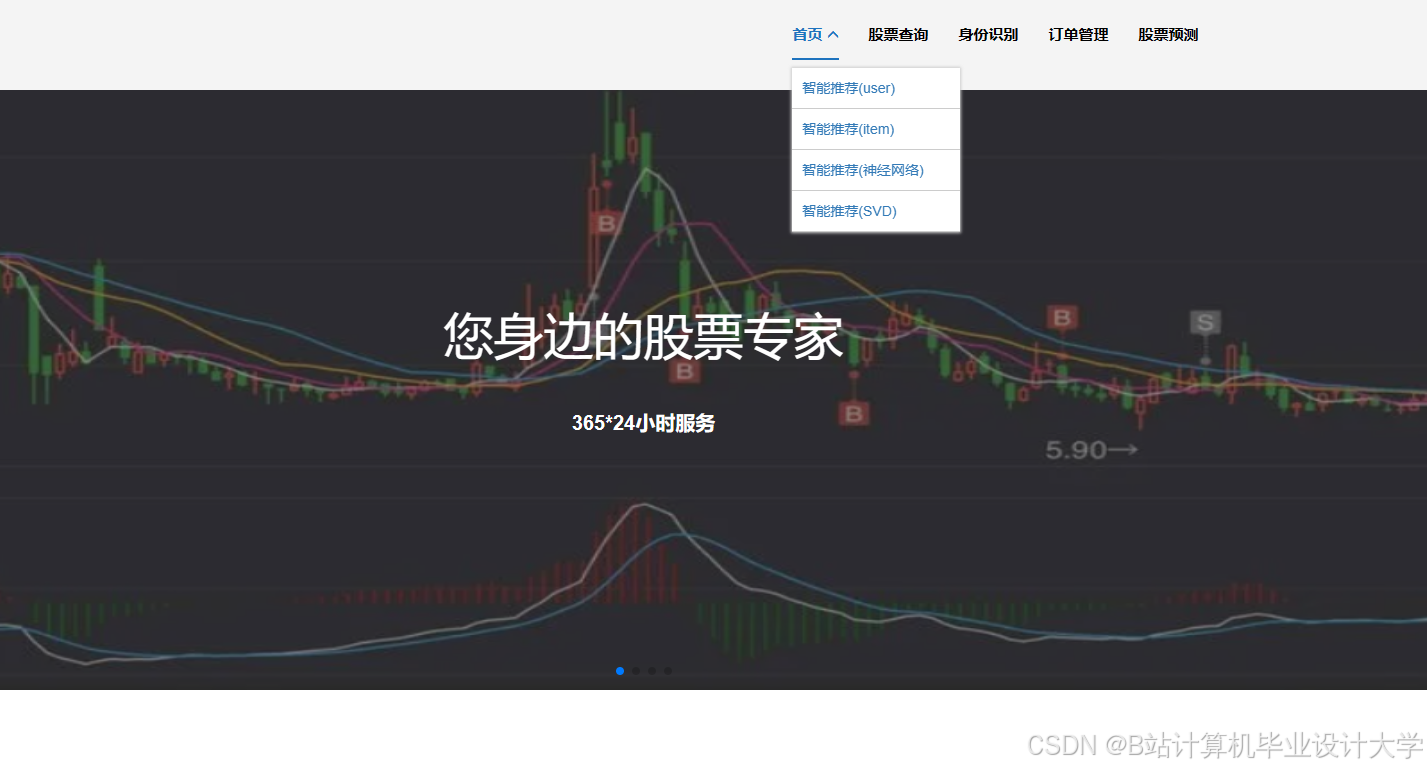

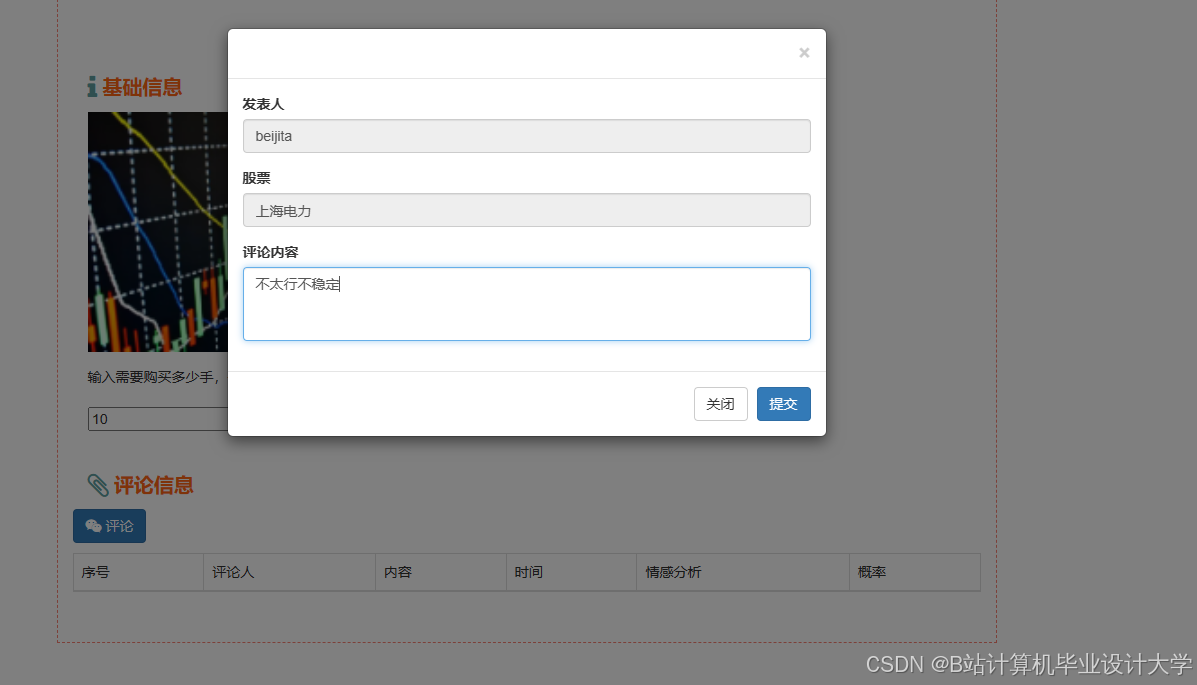

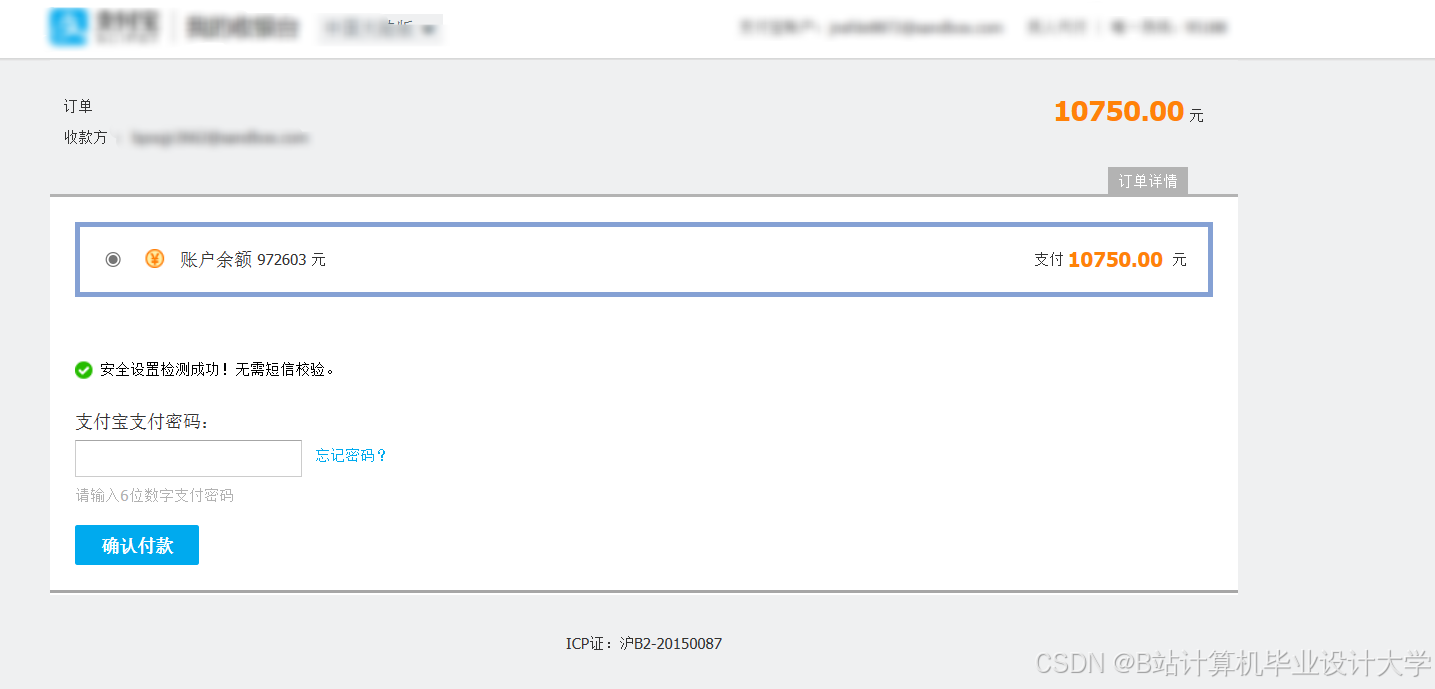

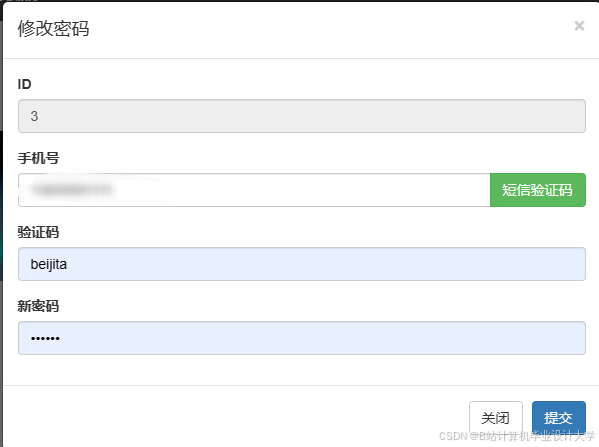

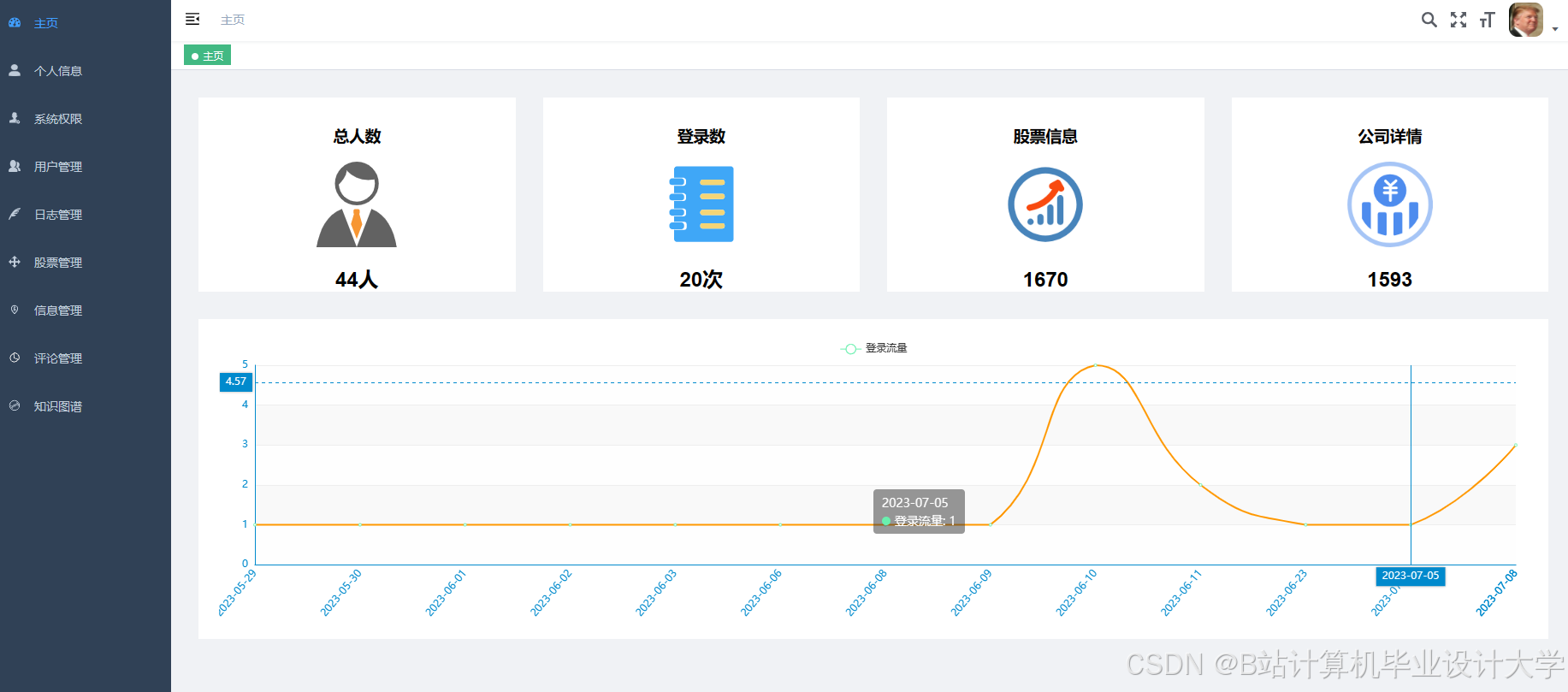

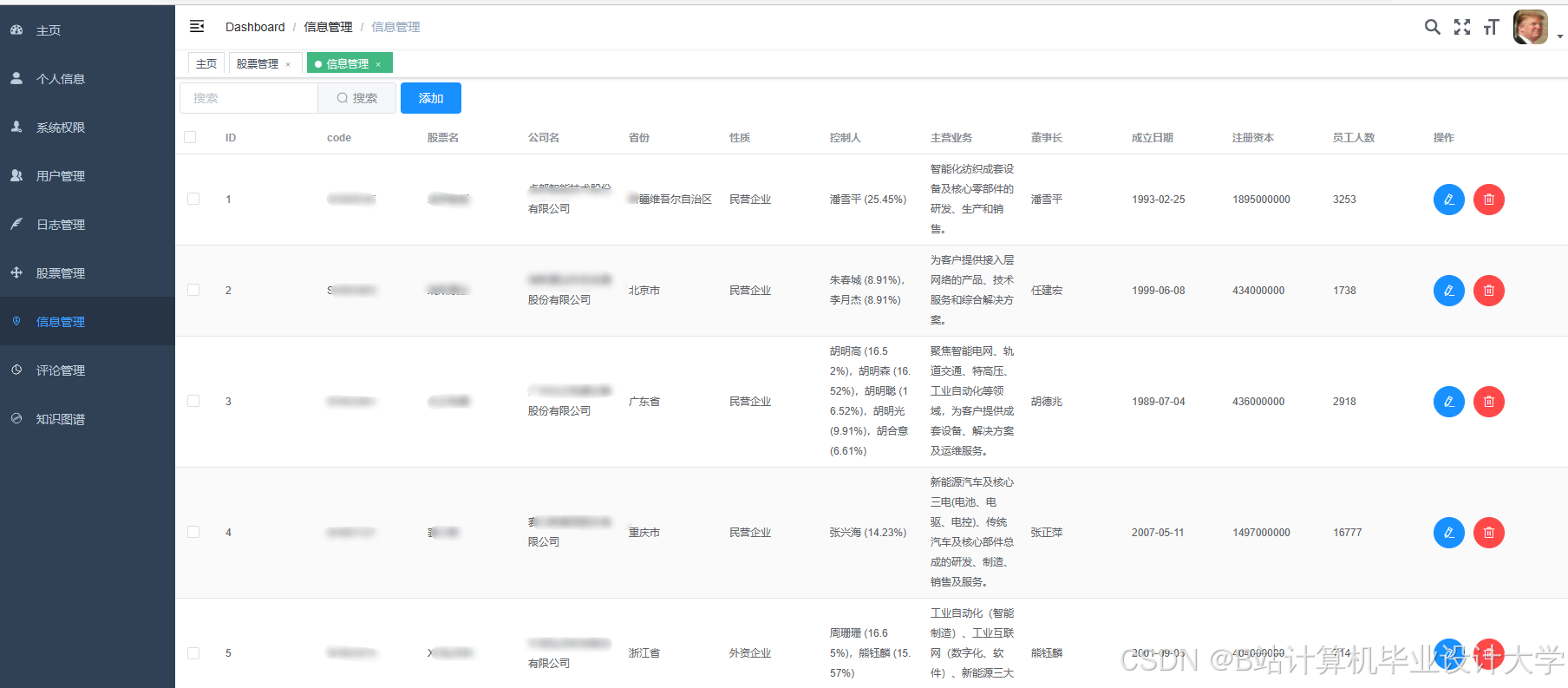

运行截图

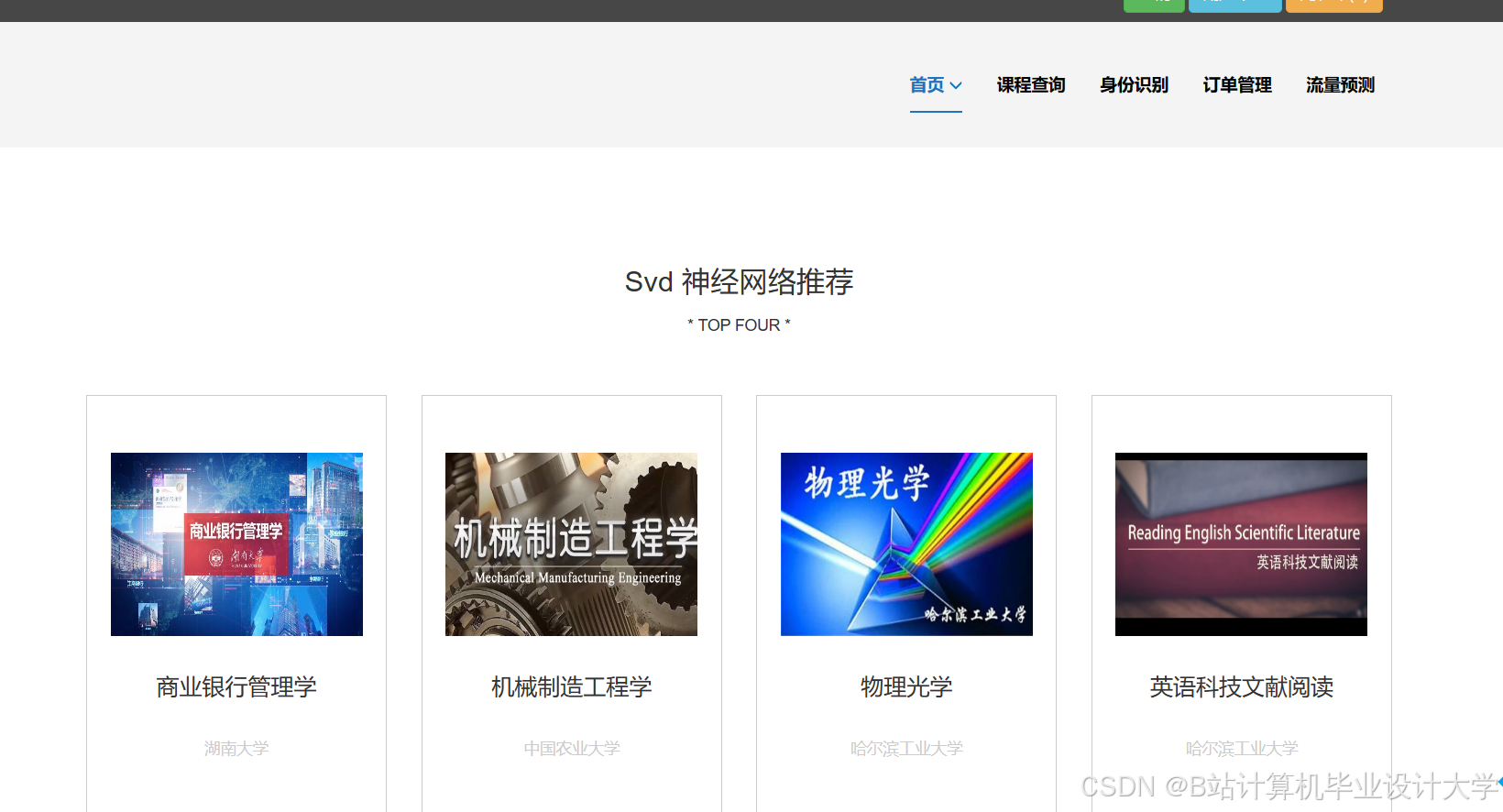

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是CSDN毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是CSDN特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓