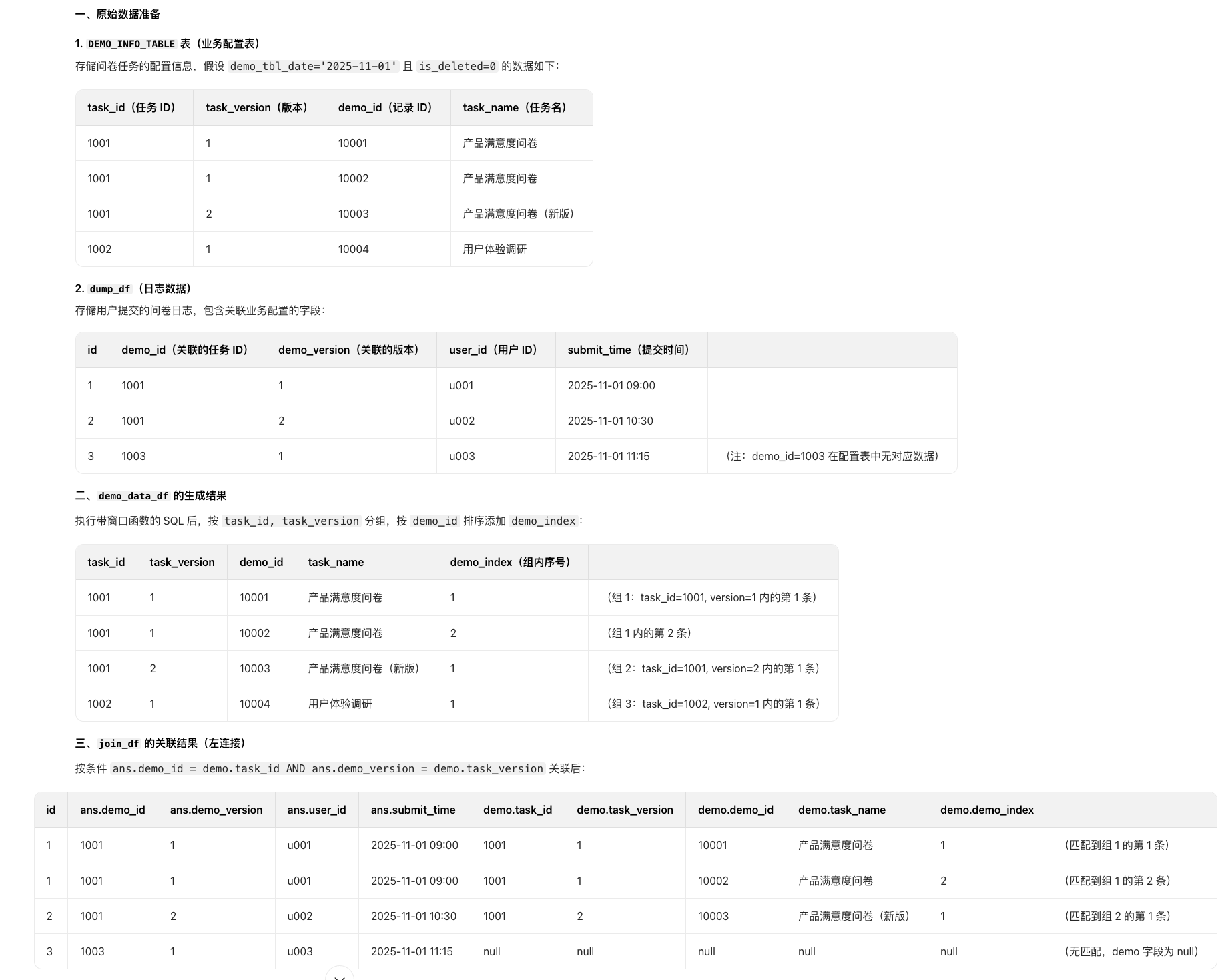

大数据 ETL 与人工智能的数据交互模式

大数据ETL与人工智能的数据交互模式:从单向管道到双向闭环的进化

引言:大数据与AI的融合趋势

在数字经济时代,大数据是燃料,**人工智能(AI)**是引擎。两者的融合催生了诸如智能推荐、风险预测、医疗诊断等一系列高价值应用。然而,数据从“原始燃料”到“引擎动力”的转换,需要一个关键的中间层——ETL(提取、转换、加载)。

想象一下:如果把AI比作一辆自动驾驶汽车,那么ETL就是“燃料处理系统”——它从油井(数据源)提取原油(原始数据),经过精炼(转换)得到高纯度汽油(结构化数据),再注入油箱(数据仓库/湖),为汽车提供动力(AI模型训练)。

但随着AI技术的演进,这种“单向燃料供应”模式已无法满足需求。现代AI系统需要动态、闭环的数据交互:比如自动驾驶汽车的传感器数据不仅要喂给模型,模型的决策(如刹车)还会产生新数据(如刹车时的路况),这些数据需要反馈给ETL,优化燃料的“精炼工艺”(如调整数据特征)。

本文将深入探讨大数据ETL与AI的四种核心数据交互模式,结合实战案例与数学模型,揭示两者融合的底层逻辑与实践路径。

一、基础概念:ETL与AI的数据需求

在讨论交互模式前,我们需要先明确两个核心角色的定位:ETL的职责与AI的数据需求。

1.1 ETL:数据处理的“精炼厂”

ETL是大数据 pipeline 的核心环节,负责将原始数据(来自数据库、日志、传感器等)转换为可用于分析或建模的结构化数据。其核心流程包括三步:

- 提取(Extract):从数据源获取数据,比如从MySQL读取用户表,从Kafka消费日志。

- 转换(Transform):清洗、加工数据,比如处理缺失值、编码分类特征、聚合统计指标。

- 加载(Load):将转换后的数据存储到目标系统,比如数据仓库(Snowflake)、数据湖(S3)或AI模型的输入目录。

举个例子:电商平台的用户行为数据(如浏览、点击、购买),ETL会将其转换为:

- 用户特征:最近7天浏览次数、平均浏览时长;

- 物品特征:最近30天销量、评分;

- 行为标签:是否购买某件商品。

1.2 AI:数据的“消费者”与“生产者”

AI模型(无论是传统机器学习还是深度学习)的性能,90%取决于数据质量。其对数据的核心需求包括:

(1)高质量:准确、完整、一致

- 准确:无错误数据(如用户年龄为“-1”);

- 完整:无缺失值(或缺失值已合理填充);

- 一致:数据格式统一(如日期格式为“YYYY-MM-DD”)。

(2)高维度:丰富的特征表达

AI模型需要多维度的特征来捕捉数据中的模式。比如推荐系统中,用户特征(年龄、性别、浏览历史)、物品特征(类别、价格、销量)、上下文特征(时间、地点)的组合,才能让模型准确预测用户偏好。

(3)时效性:实时或近实时

- 离线模型:需要T+1的批量数据(如每天更新的用户特征);

- 实时模型:需要毫秒级的流数据(如实时推荐中的用户点击流)。

(4)可解释性:特征与标签的逻辑关联

AI模型需要特征与标签之间有明确的因果关系。比如,“用户浏览时长”与“购买意愿”的正相关性,才能让模型学习到有效的模式。

1.3 两者的核心矛盾:从“供给侧”到“需求侧”

传统ETL的设计目标是满足分析需求(如生成报表),而AI的需求是满足建模需求。两者的核心矛盾在于:

- 分析需求:关注“是什么”(如月度销量);

- 建模需求:关注“为什么”(如销量增长的原因)。

因此,ETL与AI的交互,本质是将分析型数据转换为建模型数据,并通过反馈优化数据处理流程。

二、大数据ETL与AI的交互模式

根据数据流动的方向与反馈机制,ETL与AI的交互模式可分为四类:传统单向模式、AI增强ETL模式、双向闭环模式、实时交互模式。

2.1 模式一:传统单向模式(ETL→AI)—— 基础燃料供应

2.1.1 模式定义

数据流动:ETL将处理好的结构化数据(如Parquet文件)输出到数据仓库,AI模型(如Scikit-learn、TensorFlow)从数据仓库读取数据进行训练/推理。

核心逻辑:ETL是“数据生产者”,AI是“数据消费者”,两者是单向依赖关系。

2.1.2 适用场景

- 离线建模:如年度销售预测、客户 churn 分析;

- 数据需求稳定:特征与标签的定义长期不变(如用“年龄”“收入”预测“购买意愿”)。

2.1.3 实战案例:用Spark ETL喂给Scikit-learn分类模型

步骤1:环境搭建

安装Python 3.8+、Spark 3.0+、Scikit-learn 1.0+。

步骤2:ETL pipeline实现(Spark)

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, mean

from pyspark.ml.feature import Imputer, StringIndexer, OneHotEncoder, VectorAssembler

from pyspark.ml import Pipeline

# 1. 创建SparkSession

spark = SparkSession.builder.appName("TraditionalETL").getOrCreate()

# 2. 提取:读取原始数据(CSV格式)

raw_df = spark.read.csv("data/customer_data.csv", header=True, inferSchema=True)

# 数据示例:user_id, age, income, gender, purchase(是否购买:0/1)

# 3. 转换:处理缺失值、编码分类特征

# (1)填充缺失值(age、income用均值填充)

imputer = Imputer(inputCols=["age", "income"], outputCols=["imputed_age", "imputed_income"])

# (2)编码分类特征(gender:男/女→0/1→One-Hot向量)

string_indexer = StringIndexer(inputCol="gender", outputCol="gender_index")

one_hot_encoder = OneHotEncoder(inputCol="gender_index", outputCol="gender_onehot")

# (3)组合特征(将imputed_age、imputed_income、gender_onehot合并为features向量)

vector_assembler = VectorAssembler(

inputCols=["imputed_age", "imputed_income", "gender_onehot"],

outputCol="features"

)

# 4. 构建ETL pipeline

pipeline = Pipeline(stages=[imputer, string_indexer, one_hot_encoder, vector_assembler])

# 5. 执行pipeline,得到转换后的数据

transformed_df = pipeline.fit(raw_df).transform(raw_df)

# 6. 加载:保存为Parquet文件(适合AI模型读取)

transformed_df.write.parquet("data/processed_customer_data.parquet", mode="overwrite")

步骤3:AI模型训练(Scikit-learn)

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 1. 读取ETL输出的Parquet文件

df = pd.read_parquet("data/processed_customer_data.parquet")

# 2. 分割特征(features)与标签(purchase)

X = df["features"].apply(lambda x: x.toArray()) # 将Spark向量转换为Numpy数组

y = df["purchase"]

# 3. 分割训练集与测试集(8:2)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 4. 训练逻辑回归模型(预测是否购买)

model = LogisticRegression()

model.fit(X_train, y_train)

# 5. 评估模型准确率

y_pred = model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f"模型准确率:{accuracy:.2f}") # 输出示例:0.85

2.1.4 优缺点分析

- 优点:实现简单,适合数据需求稳定的场景;

- 缺点:无反馈机制——AI模型的性能问题(如准确率低)无法反向优化ETL(如是否遗漏了关键特征)。

2.2 模式二:AI增强ETL模式(AI→ETL)—— 用AI优化燃料精炼工艺

2.2.1 模式定义

数据流动:AI模型(如机器学习、深度学习)嵌入ETL pipeline,优化ETL的转换/加载步骤(如异常检测、缺失值填充、性能预测)。

核心逻辑:ETL是“数据生产者”,AI是“数据优化者”,两者是辅助关系。

2.2.2 核心应用场景

- 数据清洗:用AI检测异常值(如Isolation Forest)、填充缺失值(如随机森林);

- 转换规则优化:用AI学习转换规则(如自动识别特征工程方法);

- 性能优化:用AI预测ETL的瓶颈(如用LSTM预测数据加载延迟)。

2.2.3 数学模型:用随机森林填充缺失值

假设我们有一个数据集D = {x_1, x_2, ..., x_n},其中x_i是包含缺失值的特征向量。我们用随机森林(Random Forest)预测缺失值:

-

划分数据集:将

D分为两部分:D_obs(无缺失值的样本)、D_miss(有缺失值的样本); -

训练模型:用

D_obs训练随机森林模型,以其他特征为输入,缺失特征为输出; -

预测缺失值:用训练好的模型预测

D_miss中的缺失值。

损失函数:使用**均方误差(MSE)**评估预测效果:

MSE=1m∑i=1m(yi−y^i)2MSE = \frac{1}{m} \sum_{i=1}^m (y_i – \hat{y}_i)^2MSE=m1i=1∑m(yi−yi)2

其中:

-

m:D_miss中的样本数量; -

y_i:D_miss中的真实值(若有); -

\hat{y}_i:模型预测值。

2.2.4 实战案例:用Isolation Forest检测ETL中的异常值

问题背景:原始数据中存在异常值(如用户收入为100万,但大部分用户收入在10万以下),这些异常值会导致AI模型过拟合。

步骤1:ETL pipeline中嵌入Isolation Forest

from pyspark.sql import SparkSession

from pyspark.sql.functions import col

from pyspark.ml.feature import VectorAssembler

from sklearn.ensemble import IsolationForest

import pandas as pd

# 1. 创建SparkSession

spark = SparkSession.builder.appName("AIEnhancedETL").getOrCreate()

# 2. 提取:读取原始数据(包含异常值)

raw_df = spark.read.parquet("data/raw_sales_data.parquet")

# 数据示例:user_id, age, income, sales_amount

# 3. 转换:用Isolation Forest检测异常值

# (1)将数据转换为特征向量

vector_assembler = VectorAssembler(inputCols=["age", "income", "sales_amount"], outputCol="features")

df_features = vector_assembler.transform(raw_df)

# (2)转换为Pandas DataFrame(方便用Scikit-learn)

pandas_df = df_features.select("features").toPandas()

X = pandas_df["features"].apply(lambda x: x.toArray()).tolist()

# (3)训练Isolation Forest模型(contamination=0.01表示异常值比例为1%)

clf = IsolationForest(contamination=0.01, random_state=42)

clf.fit(X)

anomaly_labels = clf.predict(X) # -1:异常,1:正常

# (4)将异常标签添加回Spark DataFrame

pandas_df["is_anomaly"] = anomaly_labels

df_anomaly = spark.createDataFrame(pandas_df)

# (5)过滤异常值

df_clean = df_anomaly.filter(col("is_anomaly") == 1)

# 4. 加载:保存为清洁数据

df_clean.write.parquet("data/clean_sales_data.parquet", mode="overwrite")

2.2.5 优缺点分析

- 优点:提升ETL的数据质量与处理效率(如自动检测异常值,减少人工干预);

- 缺点:AI模型依赖标注数据——若没有异常值标注,Isolation Forest的效果会下降。

2.3 模式三:双向闭环模式(ETL↔AI)—— 燃料与引擎的动态协同

2.3.1 模式定义

数据流动:ETL输出的数据喂给AI模型,AI模型的推理结果(如推荐、预测)产生新数据(如用户点击),这些新数据反馈到ETL,优化ETL的特征工程(如添加新特征),形成闭环。

核心逻辑:ETL与AI是协同关系,数据在两者之间循环流动。

2.3.2 核心应用场景

- 推荐系统:用户点击推荐物品→反馈数据到ETL→更新用户特征→重新训练推荐模型;

- 风险预测:模型预测用户违约→用户实际违约→反馈数据到ETL→更新风险特征→优化模型;

- 医疗诊断:模型预测疾病→医生修正诊断→反馈数据到ETL→更新病历特征→提升模型准确性。

2.3.3 实战案例:推荐系统中的双向闭环

场景:电商平台的推荐系统,需要根据用户的点击行为反馈,优化推荐模型的特征工程。

步骤1:初始ETL pipeline(Spark)

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, count, mean

# 1. 创建SparkSession

spark = SparkSession.builder.appName("RecommendationETL").getOrCreate()

# 2. 提取:读取用户行为数据(浏览、点击、购买)

user_behavior_df = spark.read.parquet("data/user_behavior.parquet")

# 数据示例:user_id, item_id, behavior_type(浏览/点击/购买), timestamp

# 3. 转换:生成初始特征

# (1)用户特征:最近7天的点击次数

user_features_df = user_behavior_df.filter(col("behavior_type") == "点击") \

.groupBy("user_id") \

.agg(count("item_id").alias("recent_click_count"))

# (2)物品特征:最近30天的销量

item_features_df = spark.read.parquet("data/item_info.parquet") \

.groupBy("item_id") \

.agg(count("sale_date").alias("recent_sales"))

# (3)合并特征

merged_df = user_behavior_df.join(user_features_df, on="user_id", how="left") \

.join(item_features_df, on="item_id", how="left") \

.fillna(0) # 填充缺失值(如无点击的用户,recent_click_count=0)

# 4. 加载:保存为训练数据

merged_df.write.parquet("data/training_data.parquet", mode="overwrite")

步骤2:初始AI模型训练(TensorFlow)

使用**神经协同过滤(NCF)**模型,预测用户对物品的点击概率:

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, Embedding, Flatten, Concatenate

from tensorflow.keras.models import Model

from tensorflow.keras.optimizers import Adam

# 1. 加载训练数据(ETL输出的Parquet文件)

train_data = tf.data.experimental.make_parquet_dataset(

"data/training_data.parquet",

batch_size=32,

label_key="behavior_type" # 标签:是否点击(1=点击,0=未点击)

)

# 2. 定义NCF模型

# (1)输入层(用户ID、物品ID、用户特征、物品特征)

user_id_input = Input(shape=(1,), name="user_id")

item_id_input = Input(shape=(1,), name="item_id")

user_features_input = Input(shape=(1,), name="recent_click_count") # 用户特征:最近7天点击次数

item_features_input = Input(shape=(1,), name="recent_sales") # 物品特征:最近30天销量

# (2)嵌入层(将用户ID、物品ID转换为低维向量)

user_embedding = Embedding(input_dim=10000, output_dim=32)(user_id_input)

user_embedding_flat = Flatten()(user_embedding) # 形状:(batch_size, 32)

item_embedding = Embedding(input_dim=100000, output_dim=32)(item_id_input)

item_embedding_flat = Flatten()(item_embedding) # 形状:(batch_size, 32)

# (3)合并嵌入与特征

merged = Concatenate()([user_embedding_flat, item_embedding_flat, user_features_input, item_features_input])

# (4)全连接层(非线性转换)

dense1 = Dense(64, activation="relu")(merged)

dense2 = Dense(32, activation="relu")(dense1)

output = Dense(1, activation="sigmoid")(dense2) # 输出点击概率(0-1)

# 3. 构建模型

model = Model(

inputs=[user_id_input, item_id_input, user_features_input, item_features_input],

outputs=output

)

# 4. 编译模型( binary_crossentropy 适用于二分类问题)

model.compile(optimizer=Adam(learning_rate=0.001), loss="binary_crossentropy", metrics=["accuracy"])

# 5. 训练模型( epochs=10 表示训练10轮)

model.fit(train_data, epochs=10)

# 6. 保存模型(用于后续推理)

model.save("models/recommendation_model.h5")

步骤3:模型推理与数据反馈

import tensorflow as tf

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, current_timestamp

# 1. 加载训练好的推荐模型

model = tf.keras.models.load_model("models/recommendation_model.h5")

# 2. 生成推荐列表(以用户ID=123为例)

user_id = 123

item_ids = [456, 789, 1011] # 候选物品ID

# (1)获取用户特征(recent_click_count)

user_features = spark.read.parquet("data/user_features.parquet") \

.filter(col("user_id") == user_id) \

.select("recent_click_count") \

.collect()[0][0]

# (2)获取物品特征(recent_sales)

item_features = spark.read.parquet("data/item_features.parquet") \

.filter(col("item_id").isin(item_ids)) \

.select("item_id", "recent_sales") \

.toPandas()

# (3)构造模型输入(用户ID、物品ID、用户特征、物品特征)

input_data = {

"user_id": [user_id] * len(item_ids),

"item_id": item_ids,

"recent_click_count": [user_features] * len(item_ids),

"recent_sales": item_features["recent_sales"].tolist()

}

# (4)模型推理(预测点击概率)

click_probabilities = model.predict(input_data)

# (5)生成推荐列表(按点击概率排序)

recommendation_list = sorted(zip(item_ids, click_probabilities), key=lambda x: x[1], reverse=True)

print(f"用户{user_id}的推荐列表:{recommendation_list}")

步骤4:反馈数据到ETL,优化特征工程

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, count, mean

# 1. 收集用户点击数据(从日志中提取)

user_click_df = spark.read.parquet("data/user_click_log.parquet")

# 数据示例:user_id, item_id, click_timestamp

# 2. 转换:生成新的用户特征(最近7天的点击次数→最近3天的点击次数)

user_new_features_df = user_click_df.filter(col("click_timestamp") >= current_timestamp() - expr("interval 3 days")) \

.groupBy("user_id") \

.agg(count("item_id").alias("recent_3d_click_count"))

# 3. 合并新特征到初始用户特征

updated_user_features_df = spark.read.parquet("data/user_features.parquet") \

.join(user_new_features_df, on="user_id", how="left") \

.fillna(0) # 填充缺失值(如无最近3天点击的用户,recent_3d_click_count=0)

# 4. 更新ETL的转换步骤(将recent_3d_click_count添加到用户特征)

# (1)修改初始ETL的转换逻辑(如步骤1中的user_features_df)

# (2)重新生成训练数据(training_data.parquet)

# (3)重新训练推荐模型(提升推荐准确性)

2.3.4 优缺点分析

- 优点:动态优化模型性能——通过反馈数据不断更新特征,提升模型的准确性(如推荐系统的点击率提升);

- 缺点:系统复杂度高——需要监控ETL与AI模型的性能,处理反馈数据的延迟(如用户点击数据的实时性)。

2.4 模式四:实时交互模式(实时ETL→实时AI)—— 燃料与引擎的实时协同

2.4.1 模式定义

数据流动:实时ETL(如Flink)处理流数据(如用户点击日志),将处理后的实时特征(如最近1分钟的点击次数)输出到实时AI模型(如TensorFlow Serving),模型实时推理(如实时推荐),并将结果反馈到前端。

核心逻辑:ETL与AI是实时协同关系,数据处理与模型推理的延迟在秒级以内。

2.4.2 核心应用场景

- 实时推荐:用户浏览商品→实时ETL处理浏览数据→实时AI模型生成推荐→前端展示推荐结果;

- 实时风险检测:用户转账→实时ETL处理转账数据→实时AI模型预测风险→系统拦截异常转账;

- 实时监控:传感器数据→实时ETL处理→实时AI模型预测设备故障→报警。

2.4.3 技术栈

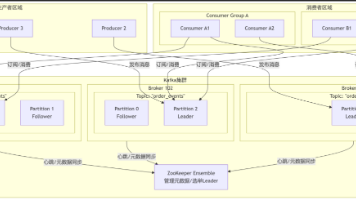

- 实时ETL:Apache Flink(流处理框架)、Apache Kafka(消息队列);

- 实时特征存储:Feast(特征存储)、Tecton(特征平台);

- 实时AI模型:TensorFlow Serving(模型推理)、TorchServe(模型推理);

- 实时数据传输:Apache Kafka(消息队列)、Redis(缓存)。

2.4.4 实战案例:实时推荐系统的实时交互

步骤1:实时ETL(Flink)处理流数据

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.Table;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

public class RealTimeETL {

public static void main(String[] args) throws Exception {

// 1. 创建流执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 2. 提取:从Kafka读取用户点击流数据

String kafkaSourceDDL = "CREATE TABLE user_click_stream (" +

"user_id INT," +

"item_id INT," +

"click_timestamp TIMESTAMP(3)" +

") WITH (" +

"'connector' = 'kafka'," +

"'topic' = 'user_click_topic'," +

"'properties.bootstrap.servers' = 'kafka:9092'," +

"'properties.group.id' = 'user_click_group'," +

"'format' = 'json'" +

")";

tableEnv.executeSql(kafkaSourceDDL);

// 3. 转换:生成实时特征(最近1分钟的点击次数)

String featureDDL = "CREATE VIEW user_real_time_features AS " +

"SELECT " +

"user_id," +

"COUNT(item_id) AS recent_1min_click_count " +

"FROM user_click_stream " +

"GROUP BY user_id, TUMBLE(click_timestamp, INTERVAL '1' MINUTE)"; // 1分钟滚动窗口

// 4. 加载:将实时特征写入Feast(特征存储)

String feastSinkDDL = "CREATE TABLE feast_sink (" +

"user_id INT," +

"recent_1min_click_count INT," +

"event_timestamp TIMESTAMP(3)" +

") WITH (" +

"'connector' = 'feast'," +

"'feast.url' = 'http://feast:6565'," +

"'feast.project' = 'recommendation_project'," +

"'feast.feature_table' = 'user_real_time_features'" +

")";

tableEnv.executeSql(feastSinkDDL);

// 5. 执行实时ETL pipeline

tableEnv.executeSql("INSERT INTO feast_sink SELECT user_id, recent_1min_click_count, click_timestamp FROM user_real_time_features");

// 6. 启动流执行环境

env.execute("RealTimeETL");

}

}

步骤2:实时AI模型推理(TensorFlow Serving)

import requests

import json

# 1. 从Feast获取实时特征(用户ID=123的最近1分钟点击次数)

feast_url = "http://feast:6565/api/v1/feature_sets/user_real_time_features/features"

params = {

"user_id": 123,

"event_timestamp": "2024-05-01T12:00:00Z"

}

response = requests.get(feast_url, params=params)

real_time_features = response.json()["features"] # 示例:{"recent_1min_click_count": 5}

# 2. 构造模型输入(用户ID、物品ID、实时特征)

input_data = {

"user_id": [123],

"item_id": [456, 789, 1011],

"recent_1min_click_count": [real_time_features["recent_1min_click_count"]] * 3

}

# 3. 调用TensorFlow Serving API进行实时推理

tf_serving_url = "http://tf-serving:8501/v1/models/recommendation_model:predict"

headers = {"Content-Type": "application/json"}

data = json.dumps({"instances": [input_data]})

response = requests.post(tf_serving_url, headers=headers, data=data)

# 4. 解析推理结果(点击概率)

click_probabilities = response.json()["predictions"][0]

print(f"实时点击概率:{click_probabilities}")

2.4.5 优缺点分析

- 优点:低延迟(秒级以内),适合实时应用场景;

- 缺点:技术复杂度高——需要掌握流处理(Flink)、特征存储(Feast)、实时推理(TensorFlow Serving)等技术。

三、实际应用场景解析

3.1 电商推荐系统

- ETL角色:处理用户的浏览、点击、购买数据,生成用户特征(如最近7天的点击次数)、物品特征(如最近30天的销量);

- AI角色:用推荐模型(如NCF、BERT4Rec)生成推荐列表;

- 交互模式:双向闭环模式——用户点击推荐物品→反馈数据到ETL→更新用户特征→重新训练推荐模型。

3.2 金融风险预测

- ETL角色:处理用户的交易数据(如转账、消费),生成风险特征(如最近1天的转账次数、转账金额);

- AI角色:用风险预测模型(如XGBoost、LightGBM)预测用户违约概率;

- 交互模式:双向闭环模式——用户实际违约→反馈数据到ETL→更新风险特征→优化模型。

3.3 医疗诊断辅助

- ETL角色:处理患者的病历数据(如症状、检查结果),生成诊断特征(如体温、血压);

- AI角色:用诊断模型(如CNN、Transformer)预测疾病类型;

- 交互模式:双向闭环模式——医生修正诊断→反馈数据到ETL→更新病历特征→提升模型准确性。

四、工具与资源推荐

4.1 ETL工具

- 批处理ETL:Apache Spark(分布式批处理)、Apache Hive(数据仓库);

- 实时ETL:Apache Flink(流处理)、Apache Kafka(消息队列);

- 工作流调度:Apache Airflow(任务调度)、Apache Oozie(Hadoop生态调度)。

4.2 AI框架

- 传统机器学习:Scikit-learn(简单模型)、XGBoost(梯度提升树)、LightGBM(轻量梯度提升树);

- 深度学习:TensorFlow(谷歌)、PyTorch(Facebook)、JAX(谷歌);

- 推荐系统:RecBole(推荐系统工具包)、TensorFlow Recommenders(TF推荐库)。

4.3 特征存储

- 开源:Feast(特征存储)、Tecton(特征平台);

- 云服务:AWS SageMaker Feature Store(AWS)、Google Cloud Vertex AI Feature Store(Google)。

4.4 资源推荐

- 书籍:《大数据ETL实战》(王健)、《人工智能:一种现代的方法》(罗素);

- 在线课程:Coursera《大数据工程》(IBM)、Udacity《深度学习》(Google);

- 社区:Apache Spark社区(https://spark.apache.org/)、TensorFlow社区(https://www.tensorflow.org/)。

五、未来发展趋势与挑战

5.1 未来发展趋势

- 自动ETL:用AutoML技术自动生成ETL的转换规则(如自动识别特征工程方法);

- 联邦ETL:支持分布式数据处理,符合隐私保护法规(如GDPR);

- 多模态ETL:处理文本、图像、音频等多模态数据,生成多模态特征(如用CNN提取图像特征);

- 实时交互深化:实时ETL与实时AI的融合更加紧密,延迟降到亚秒级(如实时推荐的延迟在100ms以内)。

5.2 挑战

- 数据质量:AI模型对数据质量非常敏感,如何检测和处理脏数据(如重复数据、错误数据)是关键;

- 时效性:实时AI需要实时数据,如何优化ETL的性能(如减少延迟)是挑战;

- 隐私:AI模型处理敏感数据(如用户的个人信息),如何满足数据隐私法规(如GDPR)是难点;

- 可扩展性:随着数据量的增长,如何用分布式计算(如Spark、Flink)处理大规模数据是挑战。

六、结论

大数据ETL与AI的交互模式,从传统单向模式到双向闭环模式,再到实时交互模式,本质是数据流动的进化——从“单向供给”到“动态协同”,再到“实时协同”。

对于数据工程师来说,需要掌握ETL的核心技能(如数据清洗、特征工程),并了解AI的数据需求(如特征与标签的逻辑关联);对于AI算法工程师来说,需要了解ETL的工作流程(如数据处理的步骤),并学会用AI优化ETL(如异常检测、缺失值填充)。

未来,随着技术的发展,ETL与AI的融合会越来越紧密,自动ETL、联邦ETL、多模态ETL等新技术将成为趋势。作为开发者,我们需要不断学习,提升自己的跨领域技能,才能应对未来的挑战。

最后,用一句话总结本文的核心思想:

大数据ETL是AI的“燃料精炼厂”,AI是ETL的“燃料优化器”,两者的融合是实现智能应用的关键。

附录:Mermaid流程图

(1)传统单向模式:

数据源(数据库/日志)

ETL提取

ETL转换(清洗/特征工程)

ETL加载(数据仓库)

AI模型(训练/推理)

输出结果(预测/推荐)

(2)AI增强ETL模式:

数据源

ETL提取

AI增强转换(异常检测/缺失值填充)

ETL加载

AI模型

输出结果

反馈到AI增强模块(优化模型)

(3)双向闭环模式:

数据源(闭环)

ETL提取

转换(基于AI反馈的特征工程)

加载

AI模型训练

AI推理(输出结果)

用户交互(产生新数据)

数据收集

(4)实时交互模式:

实时数据源(闭环)

实时ETL(Flink)

实时特征存储(Feast)

实时AI模型(TensorFlow Serving)

前端展示(实时推荐)

用户交互(产生新数据)